▍ 摘要

基因是生命的蓝图,蛋白质是生理功能的执行者、生命现象的体现者。一个简单的蛋白质包含了数百个氨基酸,其空间结构的可能性就高达10的300次方个。蛋白质中氨基酸序列不仅决定生命现象和疾病,其空间结构同样决定生理功能和疾病,只要蛋白质的结构发生一点错误,就会诱发和导致各种疾病。因此,解析蛋白质结构已成为基因测序后,诊断疾病、研发新药和深入理解生命现象的一把重要钥匙。

随着基因组学和测序技术发展,各种组学数据以惊人的速度在产生和积累,这些数据为生物医学带来极大的机遇和挑战。科学家们正在探索如何利用人工智能、深度学习等智能技术实现更有效的组学数据分析,从而转化成有价值的生物医学知识,了解疾病致病机理,寻找至今人类未攻克疾病的治疗方式。未来,生物、医学与智能的深入交叉融合也将成为生命科学领域革命的关键点。

10月17日,YOSIA Webinar举办了“AI+基因科学”研讨会,邀请基因组学、基因编辑和生物信息的学者分享如何利用机器学习、大数据和计算方法分析人类基因组并赋能生物学研究。同时,邀请产业界代表一同探讨在人工智能的加持下基因研究未来发展的科学价值和风险对策。

点击链接观看视频:https://live.polyv.cn/watch/1934396

▍ 分享嘉宾

主持嘉宾:

· 王皓毅,未来论坛青年理事,中国科学院动物研究所干细胞和生殖生物学国家重点实验室副主任、基因工程技术研究组组长

主讲嘉宾:

· 邢 毅,费城儿童医院计算与基因组医学中心创始主任,Francis West Lewis讲席教授,宾夕法尼亚大学医学院病理学与实验医学系教授

· 梁 晗,美国德州MD 安德森癌症中心生物信息与计算生物学系杰出讲席教授、副系主任

· 卜东波,中国科学院计算技术研究所研究员

· 丛 乐,未来论坛青创联盟成员,斯坦福大学医学院病理学和遗传学助理教授

讨论嘉宾:

· 胡晋南,Sentieon公司产品总监

· 王秀杰,中国科学院遗传与发育生物学研究所研究员,博士生导师

▍ 主题报告

梁晗:基因组学大数据和人工智能:从生信工具到智能伙伴

人物介绍:

北京大学本科, 普林斯顿大学计量和计算生物学博士,现任美国德州大学MD Anderson癌症中心生物信息与计算生物学系教授和副系主任。目前他的研究方向为人工智能在癌症组学大数据分析的应用和肿瘤精准治疗。主要关注点为:开发先进的生物信息算法和工具;泛癌种综合分析;癌症RNA修饰;癌症系统生物学方法。他是多个美国政府大型科研项目的首席科学家。他担任国际癌症基因组联盟(ICGC)多种癌症全基因组共同领导人,美国癌症基因图谱 (TCGA)泛癌症分析科学组主席,美国国家癌症研究所 (NCI) 基因组数据库质控组共同主席。2013年以来,他的课题组发表 >140篇文章,包括主要通讯作者的Cell, Cancer Cell, Nature Biotechnology, Nature Methods, Nature Genetics 顶级杂志12 篇。科研工作受到美国主流媒体如《华尔街日报》和《新闻周刊 》关注。他是Cancer Cell 和Genome Biology 编委。

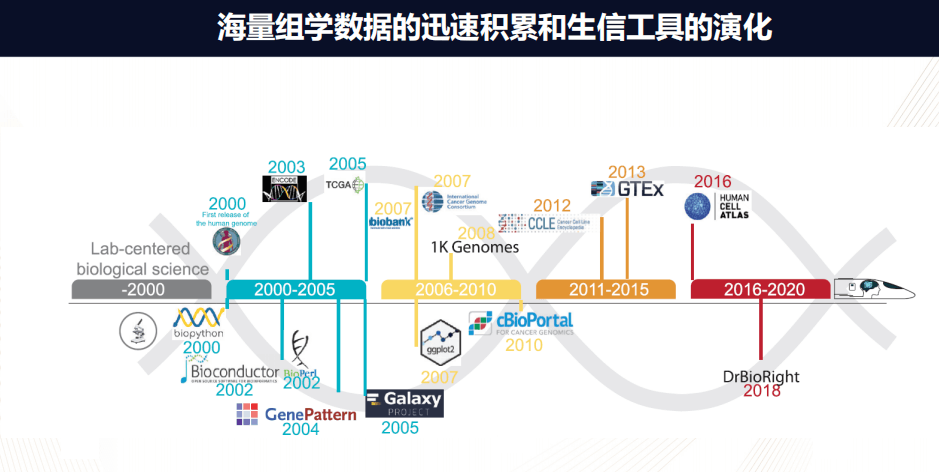

在过去的20年内,人类的生物医学发生了深刻的变化,主要发生的一件事情就是海量组学数据的迅速积累。

在2000年之前,生物学数据主要是个别的实验室产生的小规模数据;在2000年人类基因组第一次完成之后,就为以后的组学数据奠定了基础;2003年ENCODE研究基因的调控;而2005年的TCGA或者癌症基因图谱,研究解析癌症的分子图谱;2007年的biobank,ICGC,以至于到2013年的GTEx开始了解各个组织的表达图谱;到2016年的Human Cell Atlas开始研究单细胞。

这些纷纭复杂的丰富的组学数据就为我们能够全面系统的了解生物的过程,并且为疾病的治疗提供了一个非常丰富的资源。

而同时随之而来的生物信息工具在不断演化,在2000年之前,生物信息的工具主要局限在那些有计算机编程能力的人。在2000年左右出现了Biopython或者Bioconductor,这是对生物信息分析非常友好的语言,极大地降低了编程难度。而在2004年、2005年出现的GenePattern或者Galaxy,它又是能够使得科研工作者可以通过图形的界面非常有效的运行一些流程,从而不需要编程。

到了2010年,对于癌症基因组分析,例如cBioPortal,它就是对于数据的使用、分析以及最后的可视化都有非常直观可控的操作。

过去的20年之内生物信息的工具有了长足的发展,但是不可讳言的是:当我们面对这种浩如烟海的生物大数据,如果能够把这种海量的数据转化为有效的生物信息,进而汇成宝贵的生物知识,是一个非常大的挑战。

具体而言:第一,生物大数据的数量非常巨大,而数据种类又非常繁多,例如从基因组数据、蛋白质组数据、转录组数据,一直到最近的单细胞数据。

第二,虽然各种生物信息工具做的对用户越来越友好,但无论如何它存在学习成本。换句话说,这些工具对于不同人的背景又有一定的技术障碍,这取决于这个人自己的知识储备和他所掌握的计算资源。

第三,大数据分析数据结果的可重复性,现在已经成为制约生物医学发展往前进的一个重要课题。整个生物数据科学像一个飞速发展的火车,不断补充着新的数据、新的算法,理解这些工具是一个非常耗时、耗精力的过程。

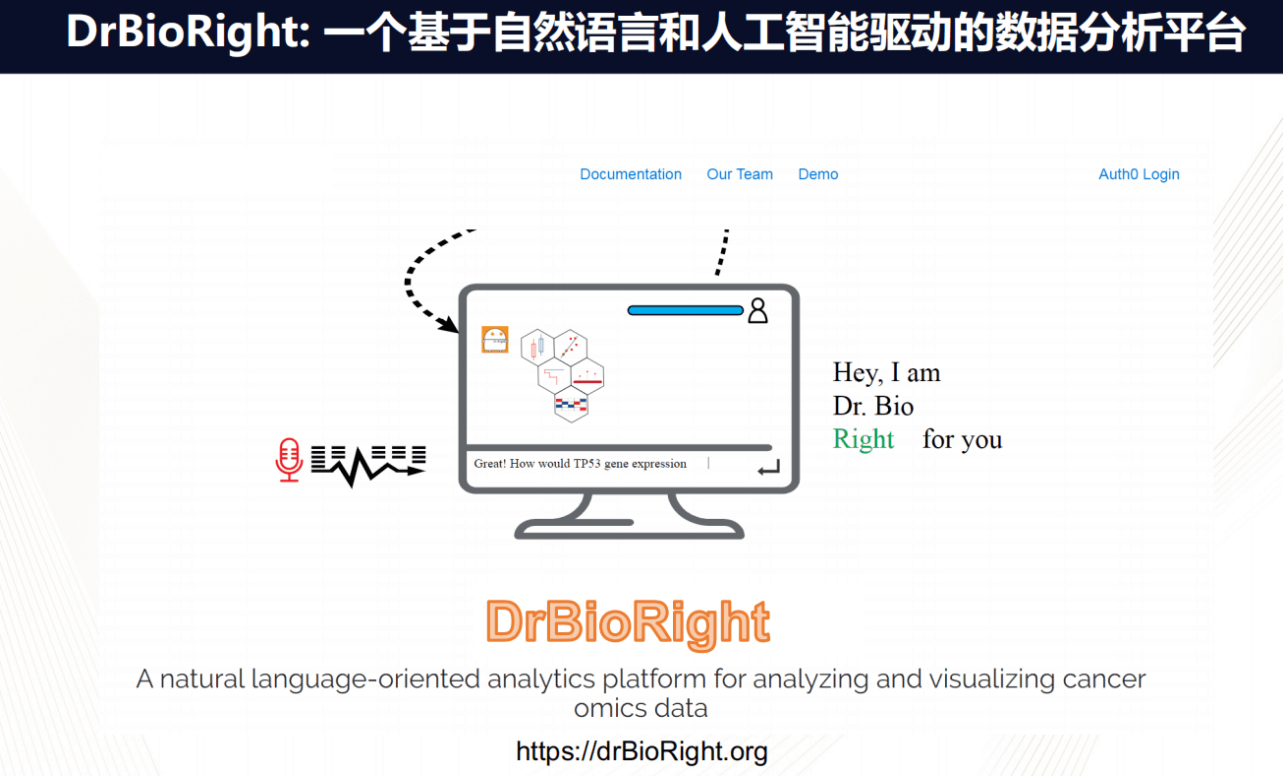

因此,基于这些挑战,我们推出了Dr.Right,名为:一个基于自然语言和人工智能驱动的数据分析平台。它主要有两个特点:一是基于自然语言,语言是人类最本能的交流方式,我们希望能够进行科研工作者产生的生物问题和大数据之间的无缝接轨;二是希望它是智能化推动的平台,其分析水平可以通过用户的使用、数据的积累,不断地更新。

如上图所示数据平台的界面,和常使用的社交软件-微信类似,存在对话框,作为使用者,只需要在对话框里直接输入自己的问题,比如想问TCGA中有多少种张量的类型。

随后,Dr.Right就会理解你的问题,然后自动的调用后台的数据,把结果呈现出来。

当然,你也可以进一步问各种问题,例如:TP53基因表达和病人的存活之间有没有一定的相关性?在这问题中,如果你没有指明数据集,那么Dr.Right会问你需要哪个数据集。当确认了这样的参数之后,Dr.Right就会自然的找到相应的数据,然后进行计算,从而得到病人的存活概率。

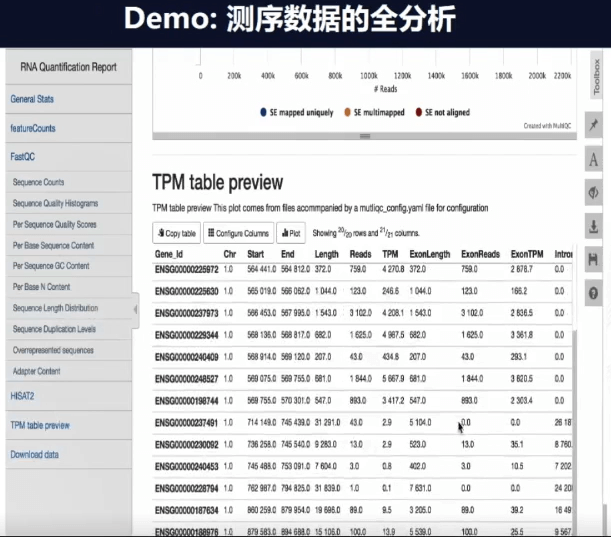

Dr.Right不但可以进行高层次的数据分析,它也可以帮助我们处理NGS最底层的分析,比如从数据全分析开始,你和系统说你可以做一个MarSeq的数据吗?然后系统就会问你几个问题,例如:项目叫什么名字等。如此,它就开始自动在后台进行处理。

当分析完成你就会自动获得一个报告,在报告上可以看到QC和序列质量等一系列指标。如果指标良好,它会自动归一化(normaliazed)数据,然后进行呈现。如上图表格,每一行就代表一个基因,表上还有基因的ID和位点,此数据也可以直接存储,也进行下一步的工作。

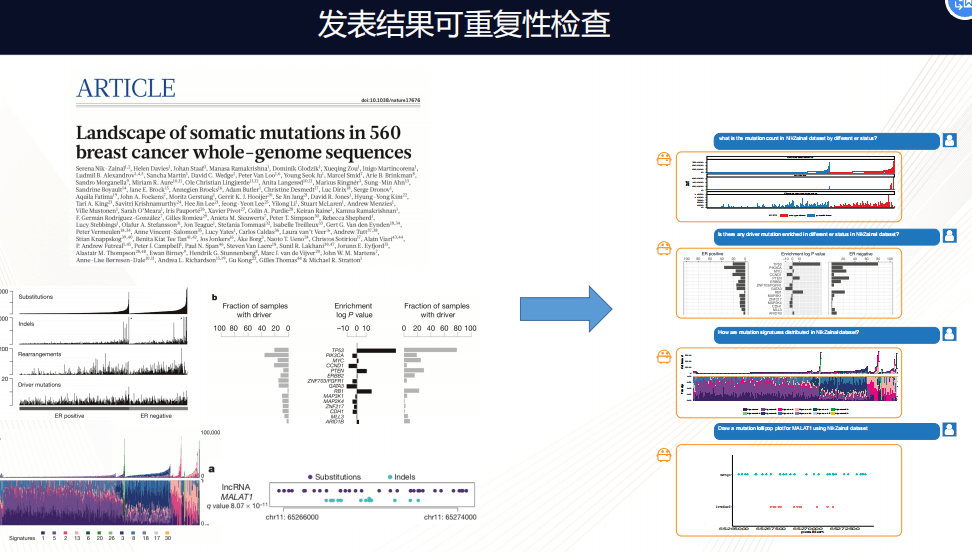

不仅Dr.Right可以进行数据分析,更重要的应用是它可以帮助检测发表结果的可靠性。

上图是《自然》去年发表的关于560个乳腺癌全基因组分析,在这篇分析中有一些组图,做了一些经典癌症组学的分析,包括找突变图谱,当把这样的数据加载在Dr.Right平台上之后,通过简单的询问几个相应的问题,图谱就可以非常完整的呈现,通过这个大家可以看到,基本百分之百重复这样的结果。这就是一个非常有效的方法,检视发表结果的可靠性。

通过以上几个例子,Dr.Right可以把以前非常冗长的生物信息分析变成一个毫无门槛的,可以实时在线的分析,就像和生物信息合作伙伴一样进行交流。

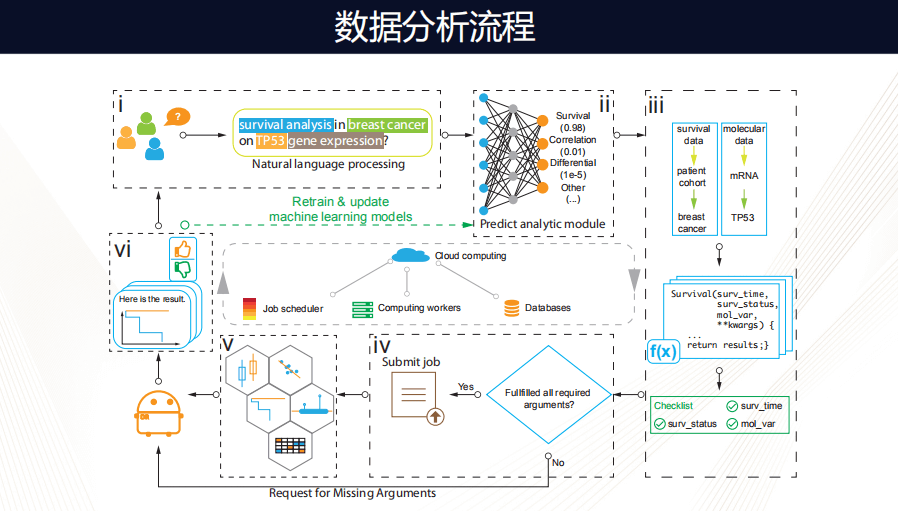

下面看一下背后数据分析的流程。首先,当我们“说”出每一句话的时候,都会使用到一个自然语言处理的包,其数据背后的模型可以帮我们预测用户想问哪些问题,当理解这个问题之后,Dr.Right找到相应数据集和相应的工作脚本,然后它会检查是否获得了它需要的全部信息,如果没有,它会继续和用户交流。

如果已经获得所有信息,它会通过一个工作脚本,然后把工作提交到计算上,如果这个工作很简单,可能在本地计算(local compute)就能解决,如果很复杂,就会需要云端的计算。

当运算完成之后,它就会选择一个优化的可视化模型,把结果呈现给用户,再通过对话框问这个用户对这次执行任务的满意程度,有这样的反馈机制,模型就会越来越精准。

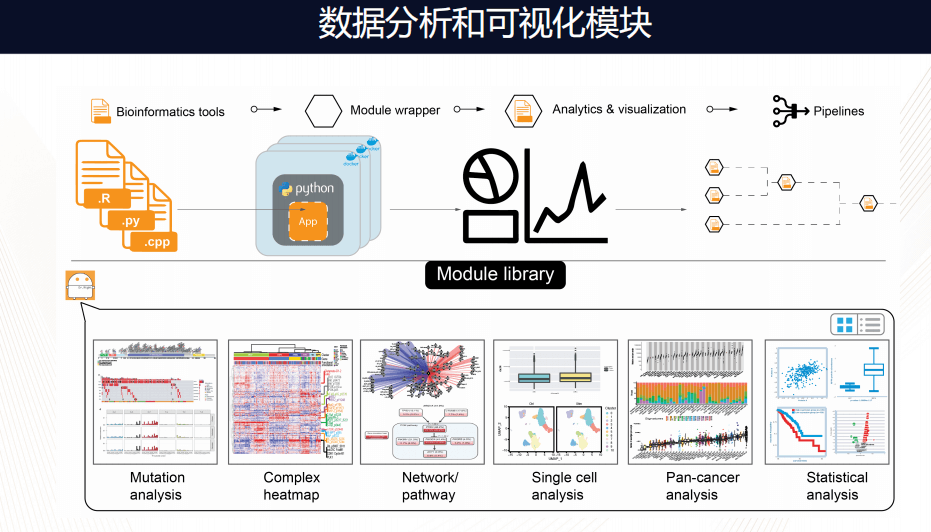

框架里的分析流程和可视化流程是模块化的,换句话说,可以非常容易把不同语言的分析化流程模块化,打包放在框架内,现在已经有几种,Mutation分析、Complex分析、网络化分析、单细胞分析、统计的工具等等。

未来还需要几点努力方向,一,希望以这个平台为基础,不断地融入更多的数据;二,我们希望Dr.Right和人的互动更加人性化,比如我们现在的模型只能帮助分析,但将来希望能够主动解释一些数据。三,希望加强Dr.Right的强大社交功能。也即不仅局限于一一对话,随着发展可以进行小组讨论,讨论过程中其公共数据和私人数据都能够看到。

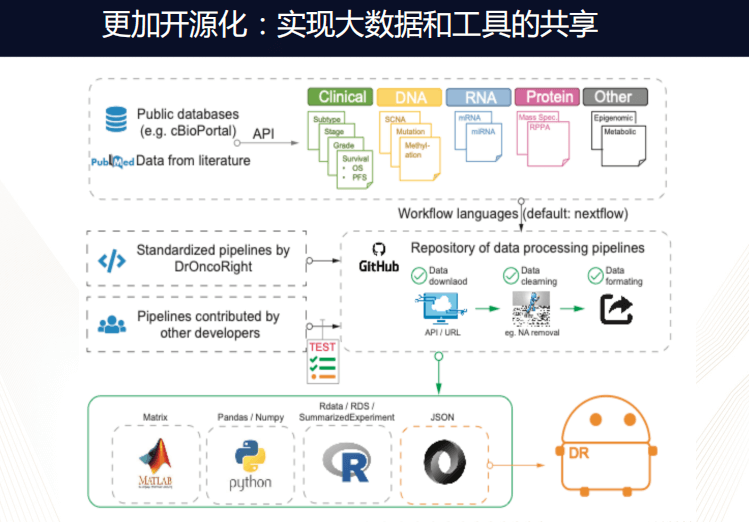

未来,此平台会实现开源化,鼓励更多人进行贡献,支持各种语言写成的流程,真正用于实现大数据的工具共享。

最后一点,也就是最重要的一点,我们希望Dr.Right的智力水平能够不断提高,也许现在看来它只是能做一些简单化分析的流程,随着用户的不断反馈,用户使用大数据的积累,最终它可以变成非常强大的工具。我们也希望能够引起新一代的智能化数据分析。

实现这一目标,首先需要有自然语言,只有自然语言能够和人进行深层次的思想交流,毕竟,人不可能对着一个冷冰冰的界面产生深层次感情连接,而通过语言的输出显然可以达到这个目的。

第二点,我们希望它使用大数据的时候,能够使我们这个平台越来越智能化。

第三点,我们希望数据分析越来越透明化,不断产生报告,也可以产生同时重复分析的脚本。

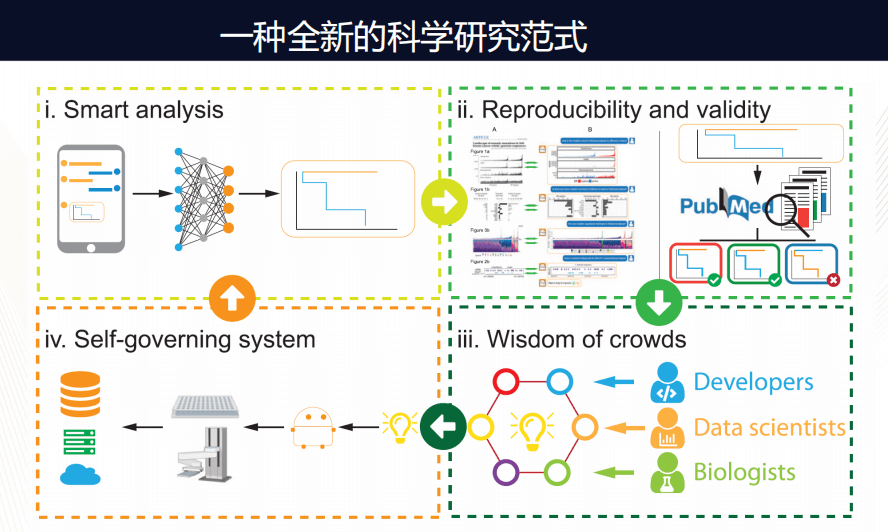

这个平台会成长为什么样子?我们打开脑洞想象:它可能就深刻改变了我们科学研究的方式。以前的研究方式是“单打独头”,即某一个人想一个问题、做实验,然后进行数据分析,自己再冥思一会儿,从而往前推进科学的研究。但有了Dr.Right,我们可以从Dr.Right的对话开始,自动帮你找到相关数据,从而进行一些数据分析,同时在公共数据可以帮助我们检测已报道文献的相关性和可重复性。然后让更多的人加入:贡献算法、数据、解释等等。当产生新的理念之后,它甚至可以调动一个自动化的机器人在实验室中自动化的实现各种实验,产生新的数据再返回,如此进行循环。

换句话说,通过这样一个自动化的分析过程,形成科学研究不再是一个人使用各种工具开发的过程,而变成了人和人工智能共同合作的过程。

另外,这个项目由李军博士牵头,陈虎、雨萌、梅茹等同学加入,是他们把最开始激动人心的想法现在变成了一个初具规模的模型。

卜东波:基于AI技术蛋白质结构预测算法

人物介绍,卜东波: 2001年于中科院计算所获得博士学位,2006-2008于加拿大滑铁卢大学计算机系访问。研究兴趣:算法设计、生物信息学(蛋白质结构预测)

这次演讲的题目是:基于人工智能技术的蛋白质结构“从头预测”方法。

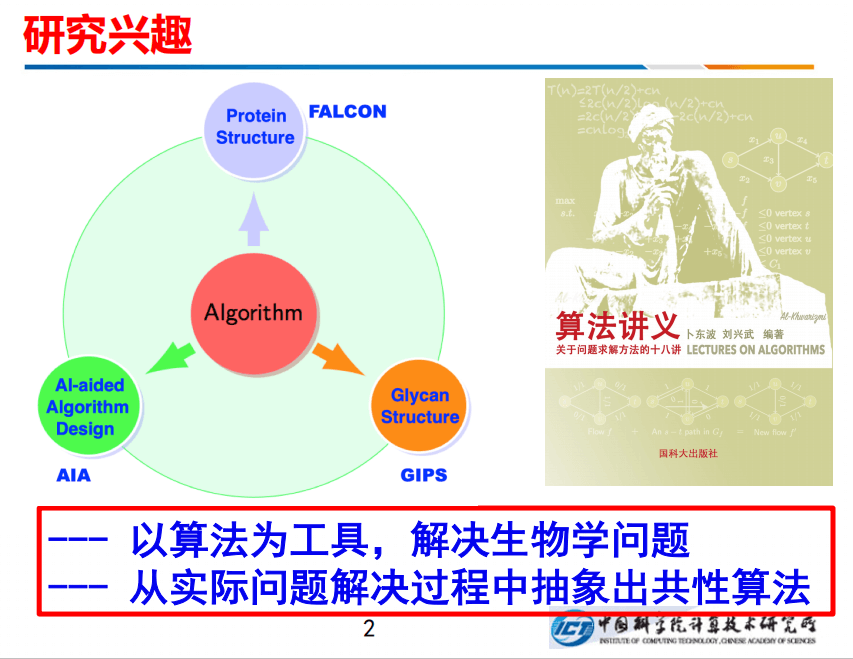

我本人一直在研究计算机算法,计算机算法是要解决实际问题的,我的主要方向有三个:一个是FALCON,进行蛋白质结构预测;一个是做糖结构的鉴定;第三个是用AI来辅助进行算法设计。总之,我的研究宗旨概括为两点:一是以算法为工具,解决生物学的实际问题;二是从实际问题的解决过程中抽象出一些共性的算法出来。另外,我最近也在写一本书叫《算法讲义》。

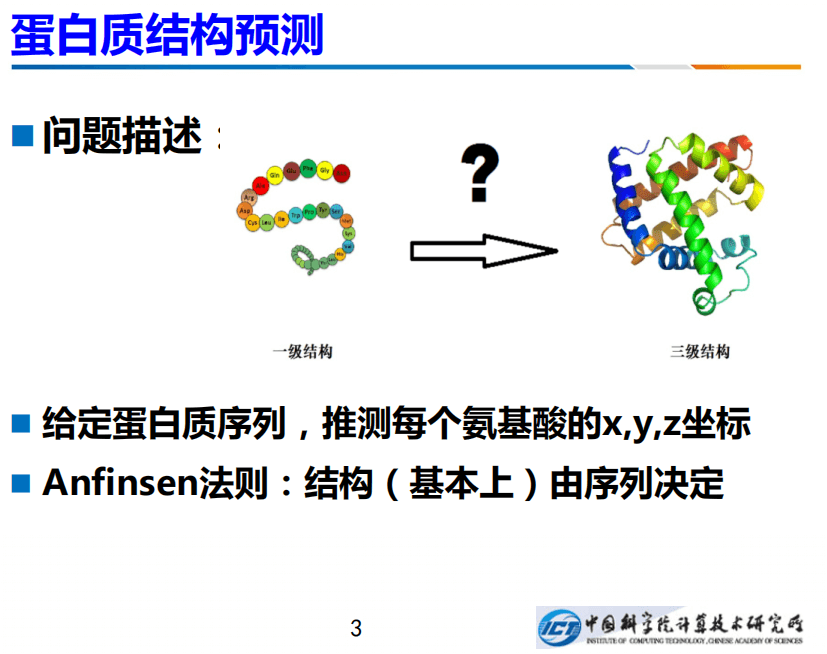

今天,我介绍一下我们在蛋白质结构预测方面的一个新的工作。什么叫蛋白质结构预测?大家都知道蛋白质是一个长长的字符串,只不过此字符不像英文是26个字母,它只有20个字母,每个字母是一个氨基酸。

在天然态中,蛋白质会固定的、自发的折叠成一个特有的构向,每个原子都有固定的坐标。也即给定蛋白质序列,可以推测每个氨基酸的x、y、z坐标。这一点也由非常著名的Anfinsen的法则作为理论支撑:结构基本上是由序列来确定的。

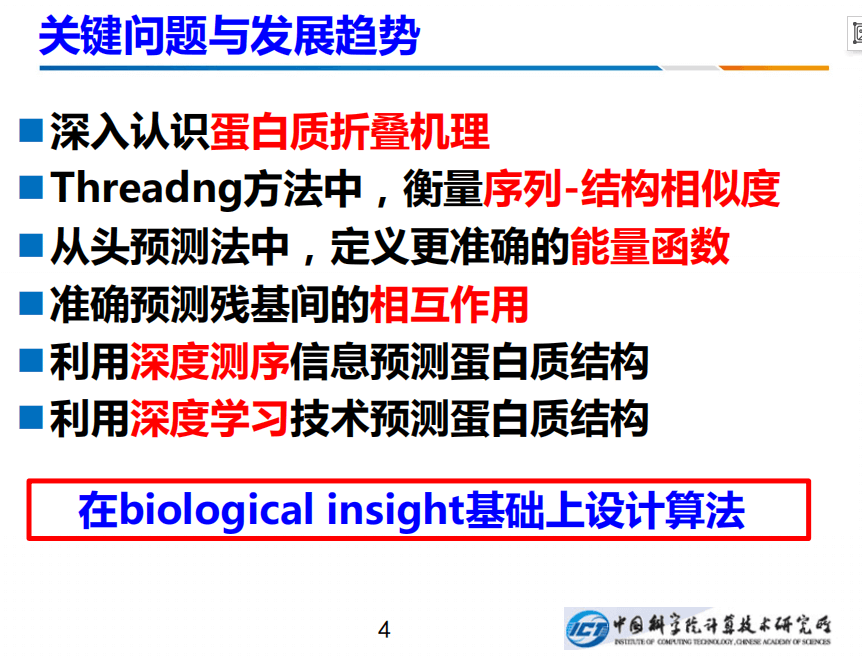

经过很长时间的研究,我们和中科院理论物理所的郑伟谋总结了一些关键问题的发展趋势:要想做好蛋白质结构预测,根本的问题是我们要深入认识蛋白质折叠的机理。在具体方法上,尤其是Threading方法中,我们要衡量待预测的序列与已知结构之间的相似度,要进行相似度的定义。

另外,在从头预测法中,能量函数是最重要的。因为我们最终要使得寻找一个能量函数最小的构象。最近一些发展表明,我们要预测残基间的相互作用,这是近几年来的进展最重要的一个突破口。

最后是两个深度,一是深度测序,尤其是宏基因组,它能够提供蛋白质结构非常重要的信息。二是深度学习。最近的一些进展表明AI技术,尤其是深度学习技术大大促进了结构预测技术的发展。

总之,我在用算法研究具体问题的时候,不会直接生搬硬套,而是在有足够洞察的基础上设计方法。

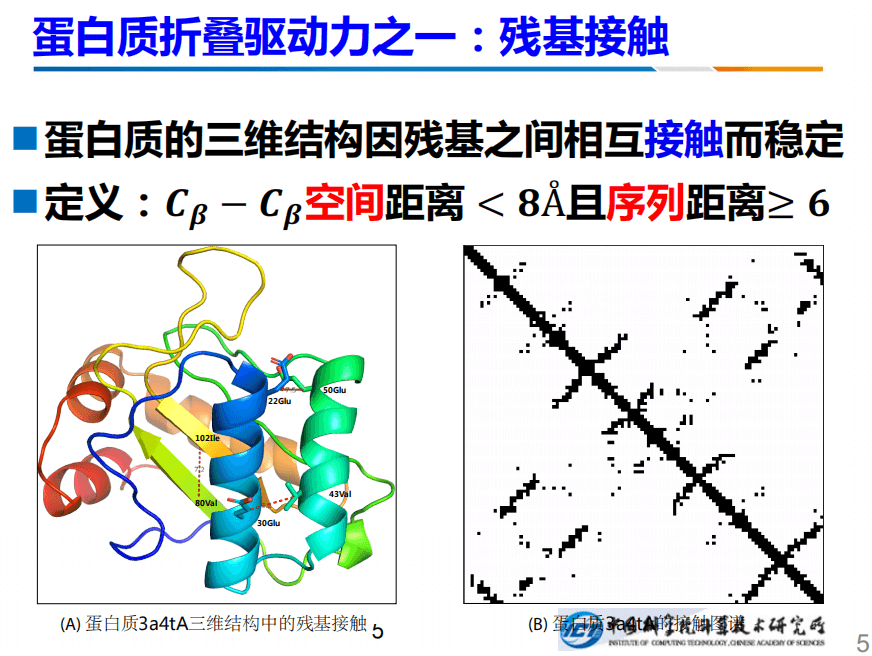

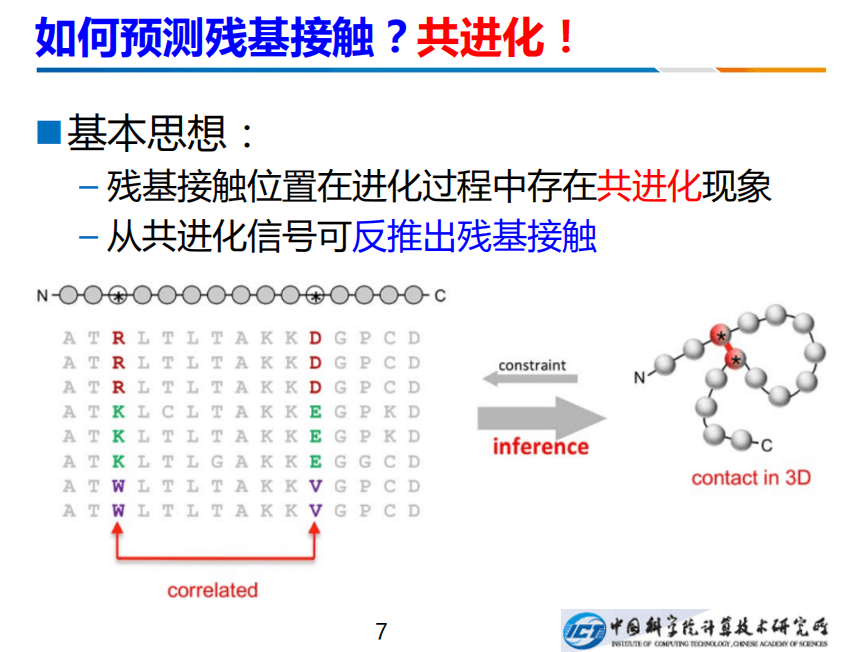

蛋白质折叠驱动之一是残基接触。所谓残基接触就是:如果两个残基之间,它俩的距离小于一个固定的值,那么我们认为它们就存在残基接触。例如左边的102和80号的蛋白质之间的距离是7.2A,小于8A,我们认为它们有接触,接触背后反映的是生物学和物理学的基础,例如数学作用、电性以及氢键等等。

所以知道了残基接触,我们就知道了每个原子的x、y、z的坐标。这件事情有非常形象的比喻,例如一个会议室里我们知道人两两之间的距离之后,就可以反推出每个人的x、y、z坐标。

换句话说,我们知道残基间的距离,就能够知道空间的结构。那么怎么预测残基间的接触呢?有一种共进化现象可以帮助我们预测。如上右图,是一个蛋白,红点的两个残基,它们之间存在相互作用。进化过程中,一个残基如果发生了变化,发生了突变,变成了另一个残基,为维持它们之间的相互作用,使得结构不散,另外一个残基也得发生相应的变化。从左边看到MSA多序列联配就能看出来,左边从R变成K,右边也要发生变化,比如从D变成E,左边的要变,右边也要跟着变。我们可以从共进化的现象当中反推出残基接触。

如果想反推,就会面对叫做传递性的困难。例如A和B存在相互作用,B和C也有,就可以推导出B和C也存在相互作用,但是这是错误的推断,因为B和C距离很远,所以传递性一直以来是非常头痛的问题。后来我们采用联合分布的方法,即每个A、B、C、D的联合分布可以非常好的克服间接关联,典型方法用马尔科夫随机场或者高斯图模型,例如高斯图模型有协方差阵,我们用它的逆矩阵,也就是精细矩阵来推动相互作用。

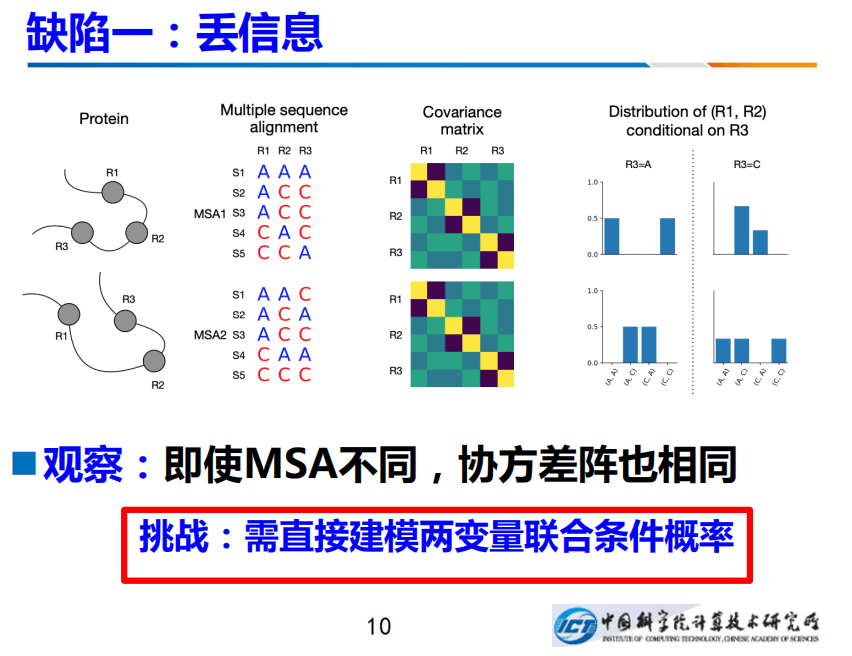

现有方法有两个缺陷,一个是信息丢失、一个是存在冲突。我们做了两个工作分别来克服这两个缺陷。第一,丢信息。左图有两个蛋白质,它们形成的MSA,采用blast或者更快的算法,能够让它进行多序列联配。注意上图两个多序列联配非常不同,可是如果按照高斯模型计算出协方差阵,针对不同单白,会得到两个一模一样的协方差矩阵,也就是说用传统的方法,协方差阵不起作用的:两个不同的蛋白居然得出一样的协方差阵,这会带来困难。

克服这种困难的一种方法是:我们直接建模两个变量的联合条件概率,右边是我画的是R1和R2这两个残基的联合概率,不过要条件性的作用在R3,建一个条件的联合概率,它们两个之间的差异就凸显出来了。这是我们的丢信息。

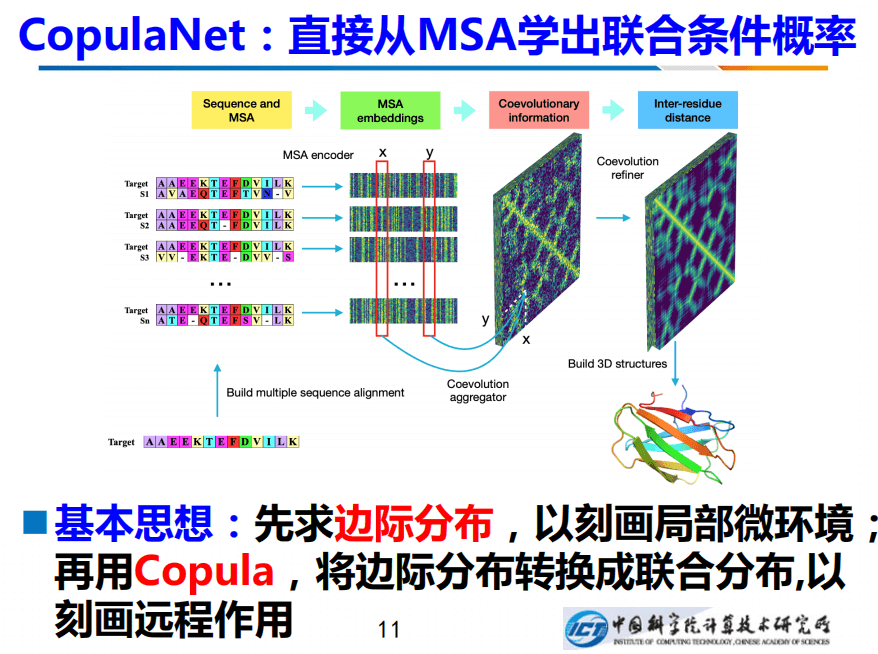

如何学出联合条件概率呢?我们设计了一个新网络CopulaNet。通过先构建MSA,然后把MSA拆成的两序列联配,将其输送给神经网络,神经网络针对每个双序列比对(Pairs alignment),都会求解出局部的微环境。从概率数理的角度来看,也就求解出每个边际分布。

明确了x位置和y位置的边际分布之后,可以采用Copula求解其联合分布,如此便能刻画远程作用,进而推断出残基间的距离。有了距离之后,便能把整个结构建起来,即构建最小化的能量函数。

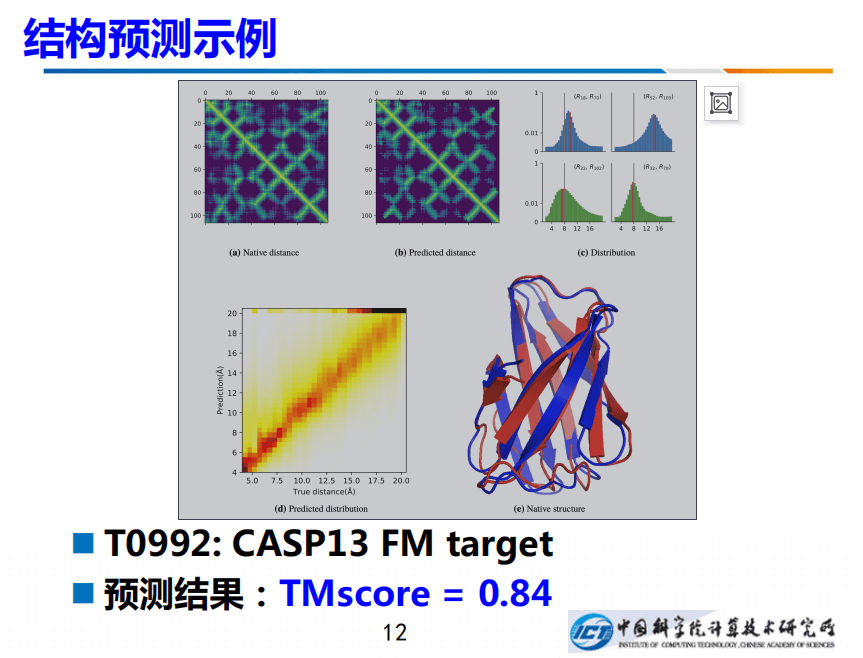

上图例子是针对CASP13 FM target T0992的操作,左边真实残基间距离的形式化的描述,右边是预测出的距离。真实距离是灰色的线,而预测出来的均值是红色的线,两者差别非常小。

左下角是直观描述,我们把所有“对”之间的距离都进行了画图,对角线表示预测的准确度,预测质量非常好,TMscore能达到0.84。

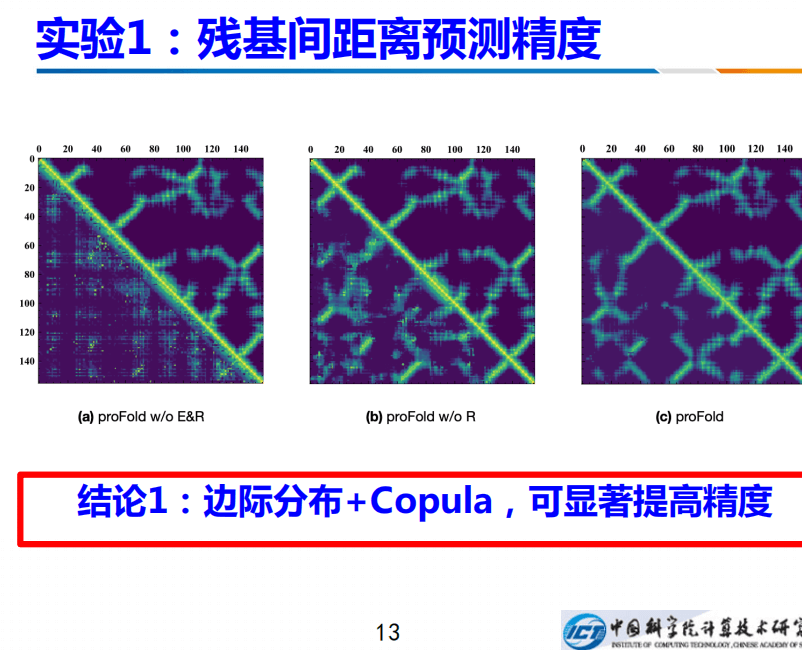

残基间距离预测精度如何?我们在CASP13的总共104个蛋白上进行测试。上图左边是不用边际分布,也不用联合分布的结果,因此对应的左下角的测结果非常差。如果加上边际分布,没有Copula的话,会有所提升;如果再加上Copula,其预测的就非常准确。因此边际分布+Copula,预测联合分布,显著提高精度。

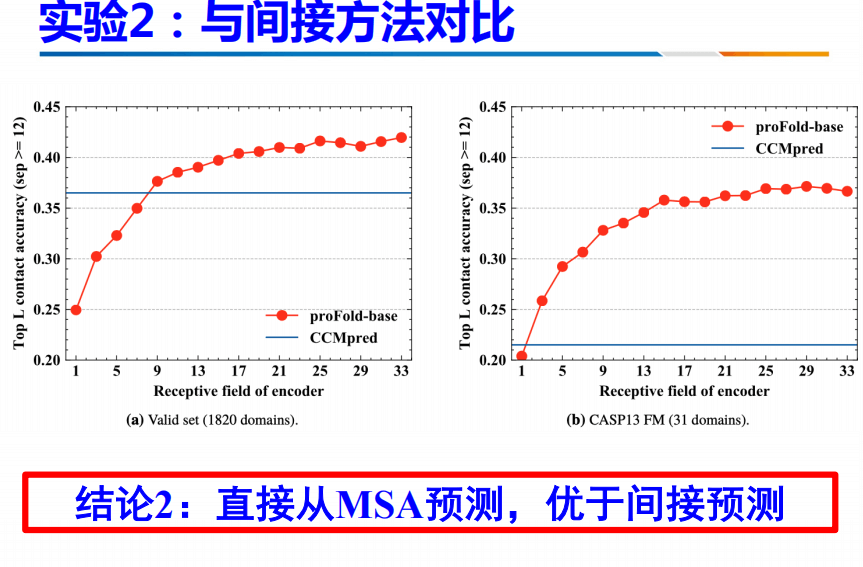

此方法与间接方法进行对比。可以发现,这种方法直接从MSA当中预测,不需要计算协方差阵。因此,优于间接预测。

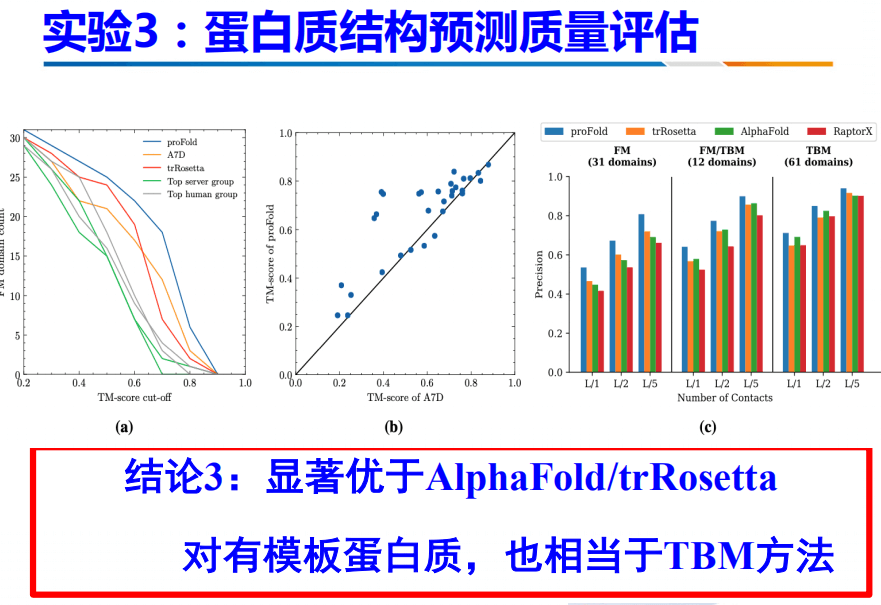

此外,我们还与当前最好的两个方法进行了对比:AlphaFold和TrRosetta。结果是显著优于AlphaFold和TrRosetta,对于有模板蛋白质,也相当于TBM方法。

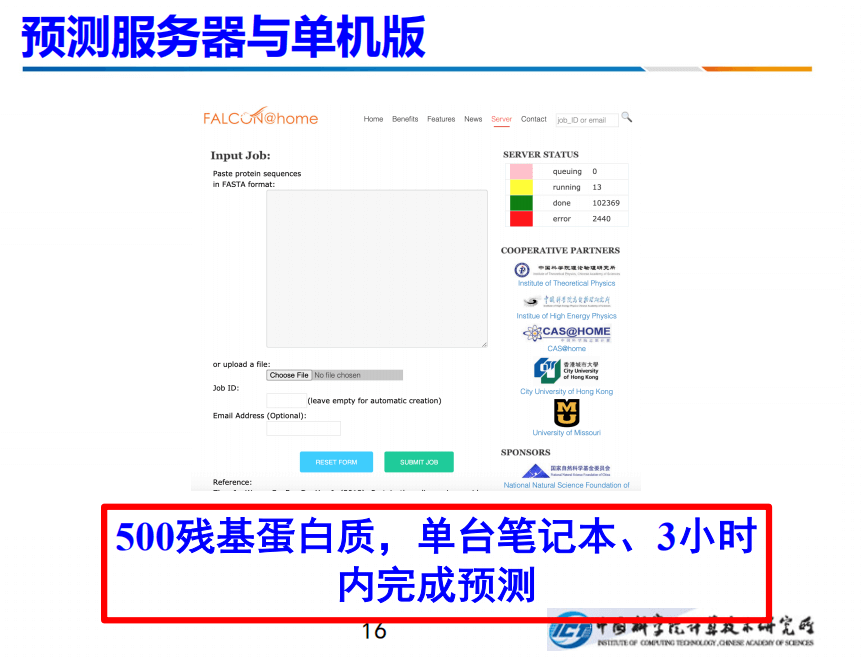

目前,我们的服务器已经上线,也有单机版可以使用。在预测效率方面,针对最长500残基蛋白质,单台笔记本,3小时之内可以完成预测。

当然也存在缺陷,即当前方法预测的残基对之间距离有冲突。根本原因在于,存在N个残基,残基间距离矩阵是N×N的矩阵,我们只需要知道它的x、y、z三个坐标就够了。因此。自由度仅为3。

换句话说,现在N×N的矩阵,其实只需要N×3就够了,剩余那些单元全部都是冗余的。由于存在冗余,就不可避免的造成很多冲突。

针对冲突,我们也进行了一些改进:用一个分布,多次采样,能有效的消除错误。

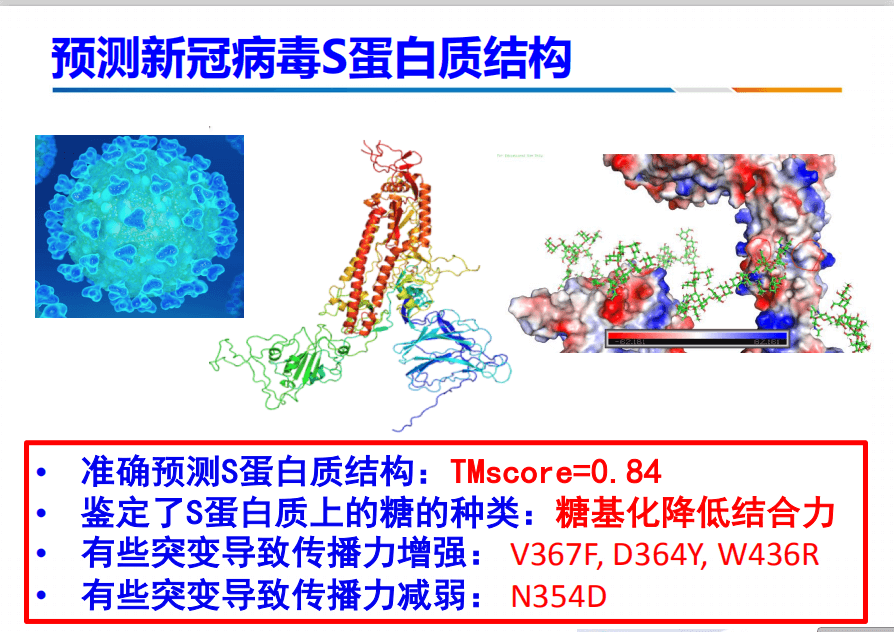

在春节的时候,我们也采用了此方法进行预测新冠病毒S蛋白质结构,准确度非常高。此外,还鉴定了S蛋白上糖。

最后总结一下思考和困惑。现在AI的进步导致我们科研方式发生很大转变,过去是洞察之后再进行理性的建模。所谓理性的建模,统计建模,背后有严格的统计学基础。

现在发生了改变,即观察后直接用神经网络,得到一些实验和结果。神经网络是一个黑箱子,有了实验结果之后还要反推原因,才能得到完美的结论。

因此,我认为科研方式发生了转变。同时有一个困惑,虽然现在蛋白质结构预测做的还不错,我们终于有点小小的突破,超过了AlphaFold,可是我们这个过程中没有新的知识,对及折叠机理的认知没有新的贡献。

邢毅:人工智能在转录组学大数据及人类疾病研究的应用

人物介绍:邢毅教授于2001年获得中国科学技术大学分子与细胞生物学学士学位和计算机科学与技术学士学位。2001-2006年,他在加州大学洛杉矶分校师从Christopher Lee教授并获得分子生物学博士学位。2006-2007年,他在斯坦福大学师从Wing Hung Wong教授和Matthew Scott教授进行博士后研究。邢毅教授在生物信息学,基因组学,和 RNA生物学有一系列的原创性成果。他目前的研究工作融合了计算生物学、RNA基因组学、人类遗传学、精准医学和肿瘤免疫学等领域。

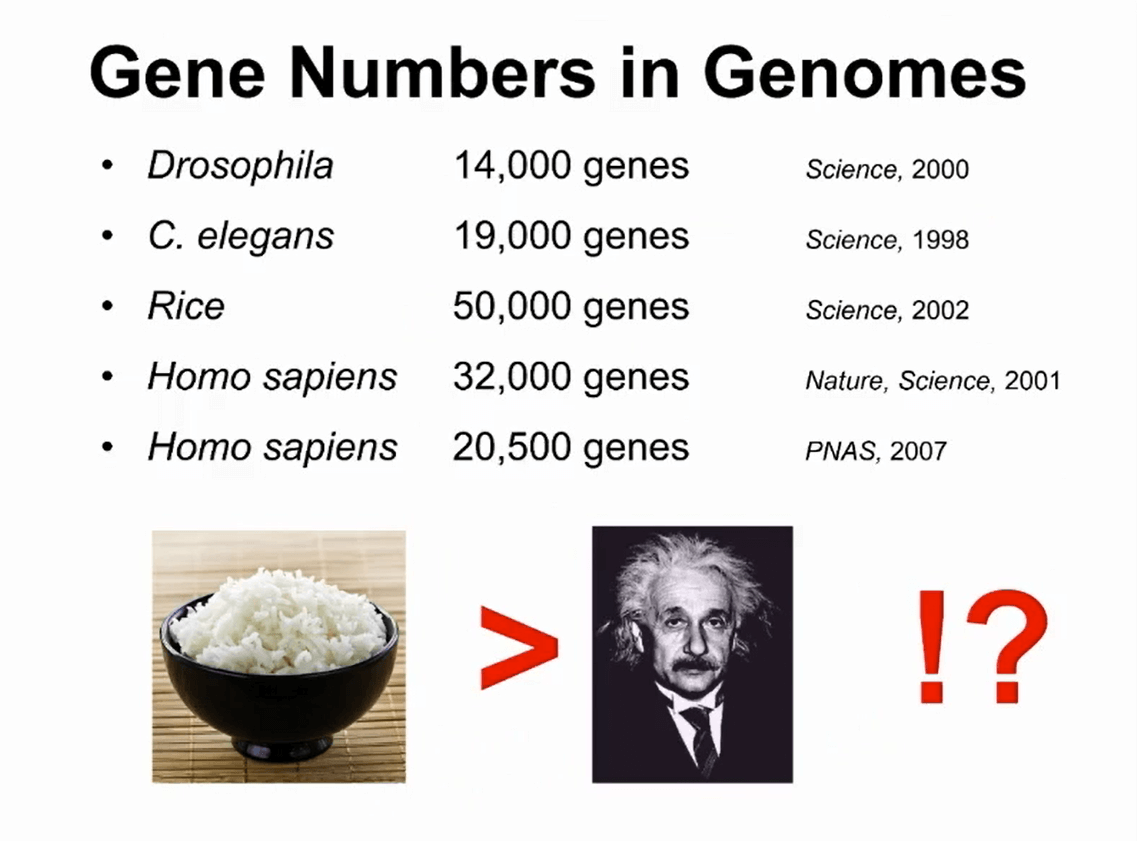

在20年前,人类基因组完成之后,有了人类第一次的基因组测序后,出现了一个非常有意思的现象:不同的基因组之间的基因数目跟物种的复杂度没有什么直接关系。

举例而言,线虫有19000个基因,水稻有50000个基因,最早人类基因组分析发现人类只有32000个基因。这个数字经过几次修改后变得越来越少,现在公认的数字是,人类大概有20000万个编码蛋白质的基因。

因此,这产生了一个非常困惑的现象,比如简单的水稻基因组,比高等的人类包含的基因数目反而更多。

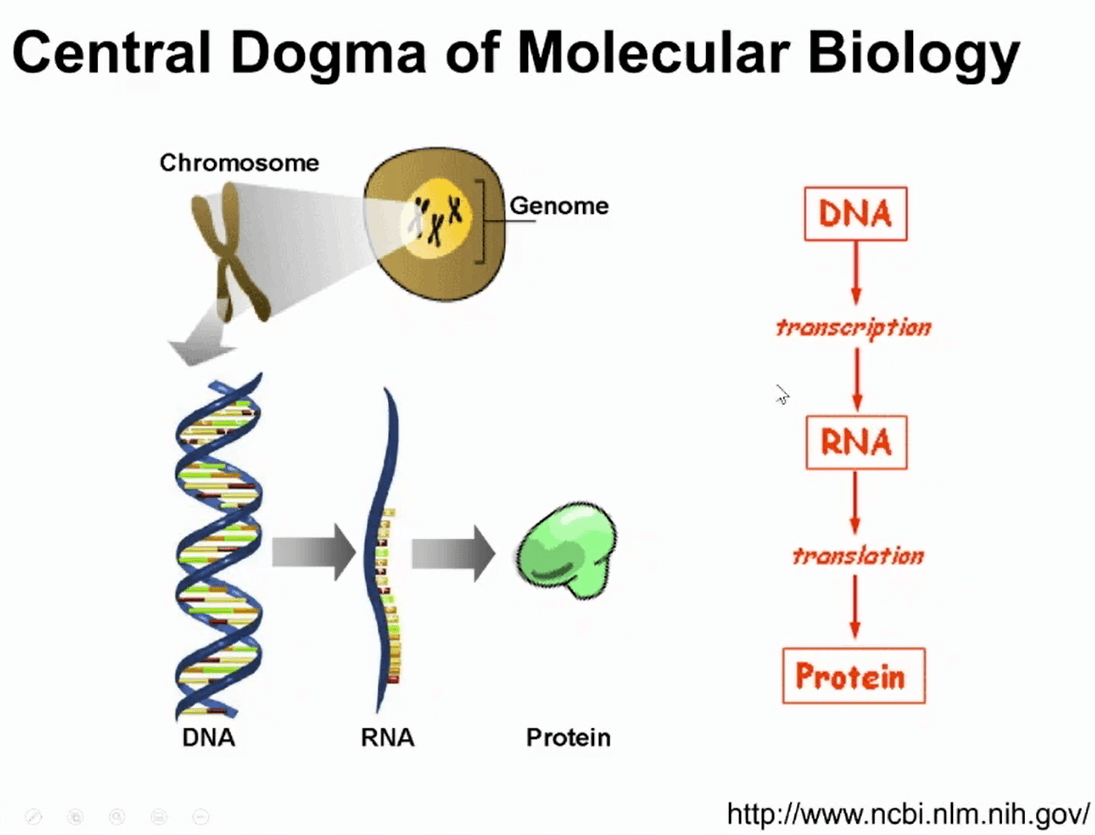

解决这个困惑,需要理解基本的分子生物学的中心法则:遗传信息是在基因组里的DNA里存储,遗传信息编码蛋白首先通过转录得到RNA,称作转录本,转录本可以翻译成蛋白质。

大家通常认为DNA是遗传信息,蛋白是功能的分子,而RNA是遗传信息的载体。

但实际上过去的几十年的研究里发现RNA本身有非常多的功能,同一个基因的RNA有各种各样的变异。另外需要值得一提的是,RNA需要通过剪切进行加工。

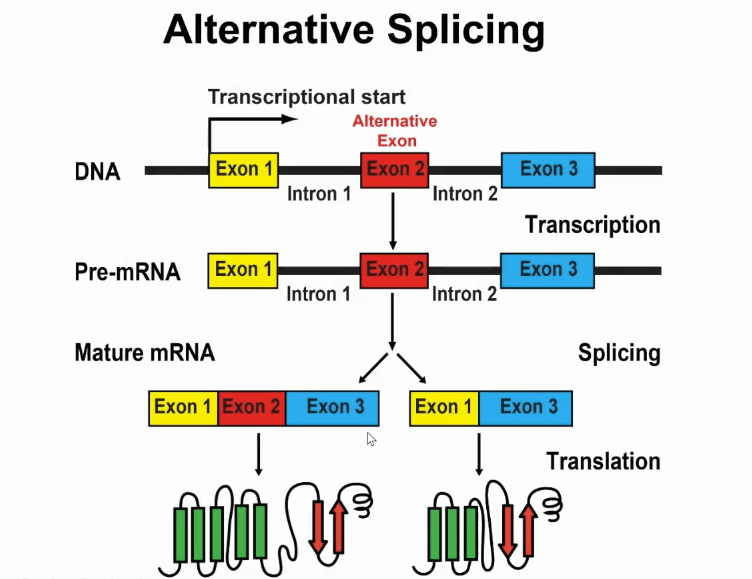

人类的大多数基因编码蛋白的部分在基因组里是不连续的,这些不连续的区域我用上图的小方框进行表示,它叫做外显子,它被一些不编码区域所间断,这些不编码区域叫做内含子(introns)。

在转录之后得到最初的RNA既有外显子也有内含子,在这之后要通过一个很重要的过程就是剪切,把内含子去掉,把外显子拼接在一起,如此才能得到一个成熟的RNA产物。

此过程其实不是一成不变的,在进行任何生物学过程中,如果出现调控过程,那么它就会出现变化,因此就出现一个现象叫做“可变剪切”。

如上图所示,就是可以发生可变剪切的基因,上图有三个外显子,第二个外显子是可变剪切的,通过可变剪切,同一个基因可以得到两个不同的RNA产物,最后可以编码成不同的蛋白质。

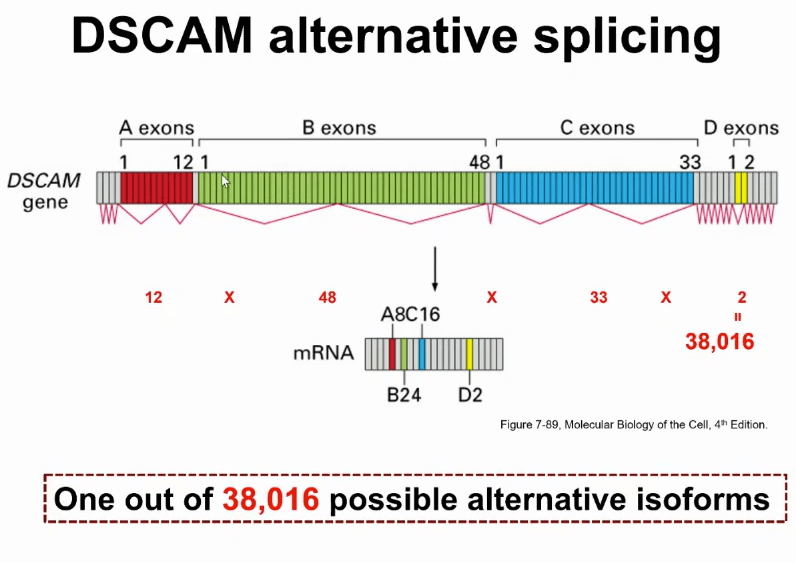

上图是一张看起来非常简单的图,但实际上此可变剪切的模式非常复杂。具体一些这是果蝇控制神经细胞分育的基因,叫做DSCAM,此基因有很多个外显子,在剪切的时候,通过一组外显子中选其中一个,如果把各种各样的组合所有全组合在一起,通过一个基因,就可以得到38000个不同RNA的转录本的产物。

这个数字有多大呢?这个数字是果蝇基因组所有基因数目的两倍多。另外,很多人类基因,尤其跟神经系统有关的基因,也会有非常多的可变剪切的方式。

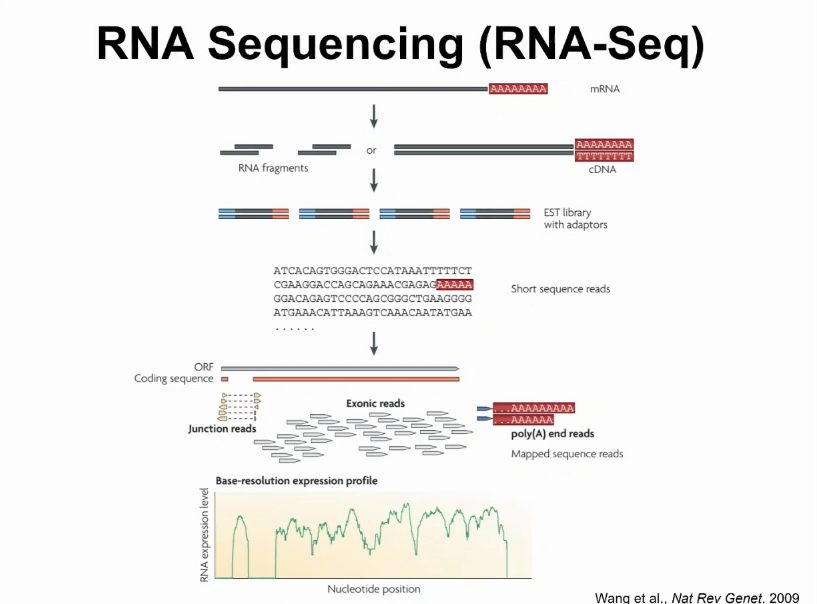

前面也提到,此方式非常复杂,我们到底如何研究它呢?在过去十几年内,随着高通量技术的发展,对RNA直接测序已经成为研究转录本非常重要和有效的工具。基本上从一个生物样本里面把RNA给取出来,然后做成一个测序文库,在上面产生大量数据。

例如,现在比较常用的illunima测序仪,可以用较低的代价,产生上亿的测序列数据,把这些数据匹配回给基因组以后,就能通过“数数”的方式观察某一个基因RNA的表达量。

因此,RNA测序技术已经广泛使用,而且非常普及了,目前有些大的国际科研项目,例如TCGA、GTEx,都在成千上万的病人样本上产生了非常海量的RNA测序数据。

因此,此类数据集给研究RNA的转录本的变异提供了非常有用的资源。但是进行分析也是比较困难的。

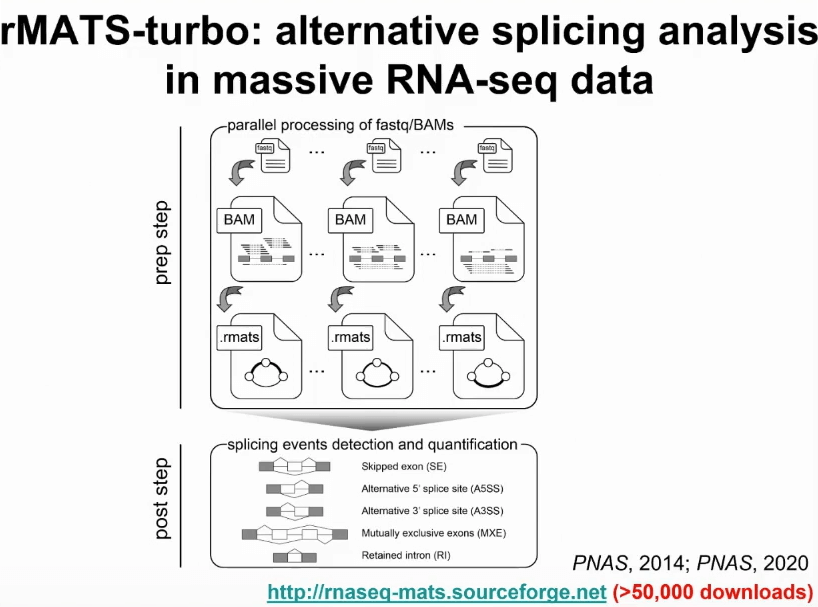

我们实验室过去十年内一个很重要的感兴趣的研究方向就是如何对海量RNA测序数据发展有效的分析,研究可变剪切或者其他转录本异构的计算学工具。另外,我们发表过一个工具叫rMATS,经过多年的维护和提升,这个工具在该领域被广泛使用。最近也升级成了rMATS-turbo,即采用一种非常有效的数据结构,能够在海量的RNA测序数据上面有效的进行可变剪切分析。

高通量测序技术也存在一些根本缺陷,很多高通量测序技术,其实是一个“数数”的问题。“数”基因到底有多少个测序数据,或者不同的RNA之间到底有多少个序列能够进行匹配。当“数数”的时候,尤其是在进行可变的转录本异构的时候,不仅计数这个基因表达有多少,而是计数此基因不同的RNA产物相互比例是多少,在推测比例的时候,只有数字非常大,才能够得到准确的比例。

以美国大选为例,要想做民调观察多少人支持川普,多少人支持拜登,只有经过大量的人数调查,才可以得出准确的结果。同样,进行RNA测序其实也是同样的问题。

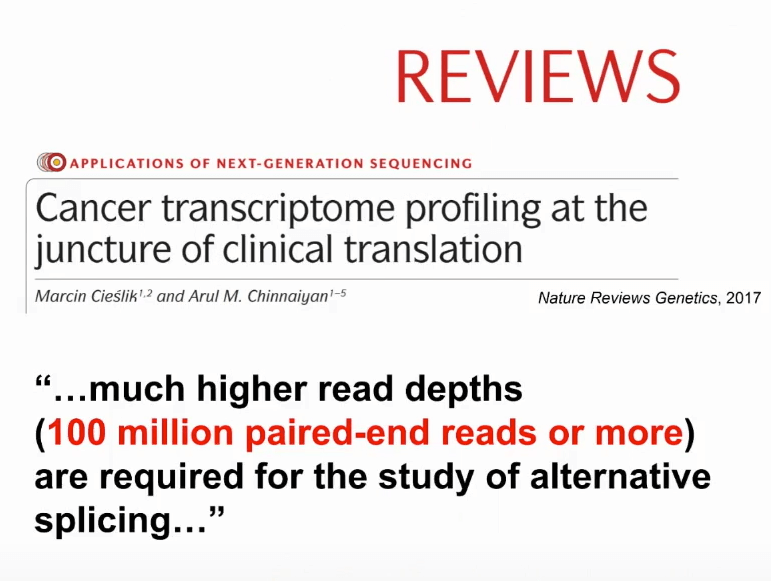

在2017年的时候,密歇根大学的著名教授Arul M. Chinnaiyan就在Nature Reviews上发表的文章,在讲述RNA测序在癌症研究当中的作用时,提到如果想要用RNA测序进行研究可变剪切时,需要非常深的测序数据,可能一条样本上需要有一亿条数据,但是绝大多数的公共数据集里面远达不到这样一个测序深度。

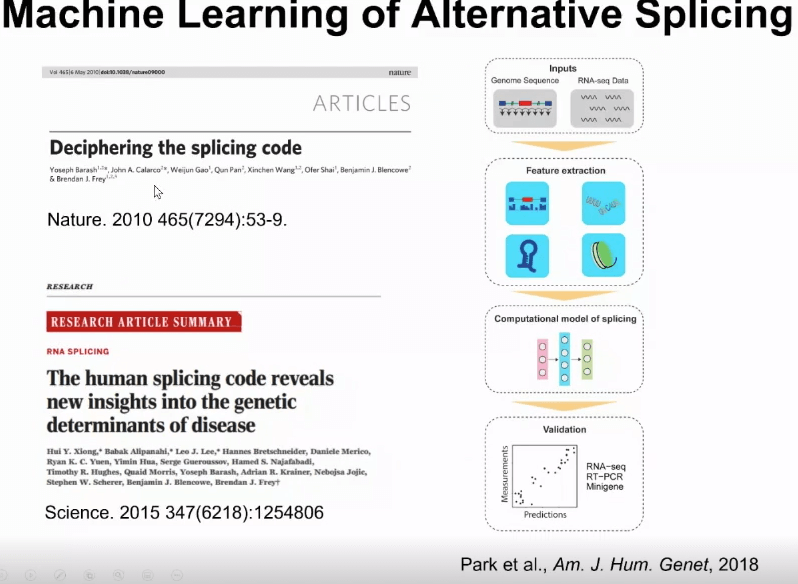

因此就产生了问题:当测序数据不够该到底怎么办。这时,机器学习和人工智能就变得有用。在数据不够的时候,可以用海量数据训练模型,从而预测转录本的异构。

此方向已经有很多工作。例如在2010年,我宾夕法尼亚大学的同事,当时他在多伦多读博士后的时候发表过一篇非常有影响力的文章,通过机器学习的方法,能够把剪切代码通过基因组的序列来预测可变剪切的模式。

在过去十年中,这个领域有一系列的工作,基本的想法是:提取出来基因组的序列,通过RNA测序数据定量得到转录本,然后在上面训练预测模型,最后用预测模型进行各种各样下游工作。

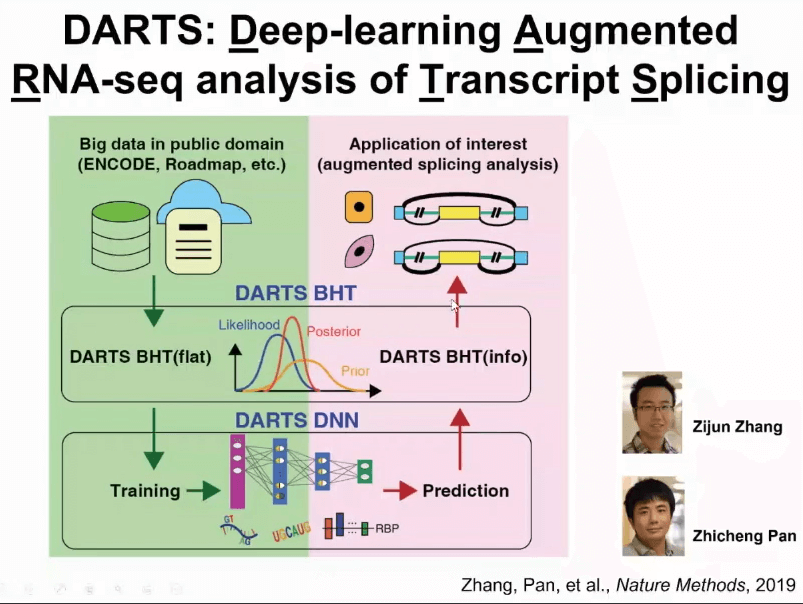

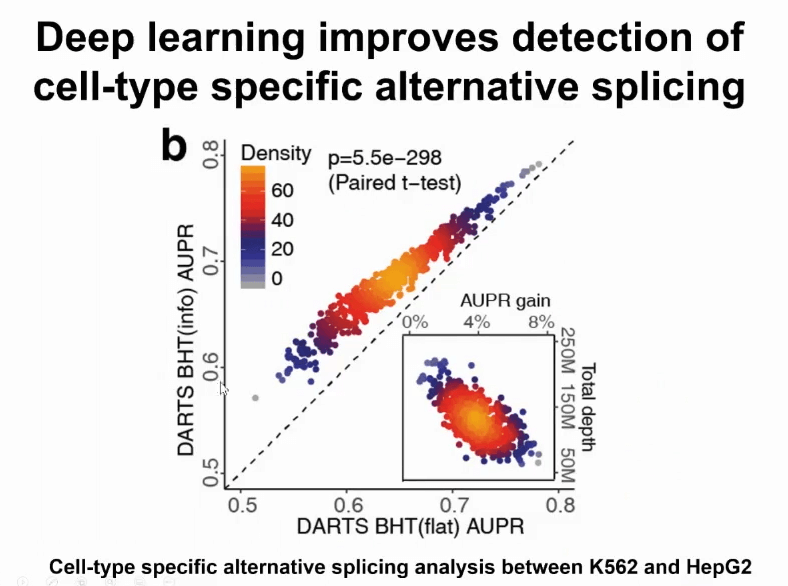

我们在几年前就开始考虑如何把机器学习或者深度学习的结果和数据结合在一起。为了解决这个问题,我们提出了一个新的计算框架叫做DARTS,大多数的科学研究者可能是在研究一个特定的生物学的问题,在这个特定的生物学系统上可能产生了一组RNA测序数据。

通过DARTS计算框架,可以用海量公共数据训练深度神经网络,此深度神经网络包括了基因组上的各种序列信息,还包括了各种细胞里面调控RNA剪切蛋白的表达含量。用这些信息可以预测出来哪些基因可能会出现剪切或者异构体水平上的变化。

值得一提的是,深度神经网络得到的预测结果,是先验概率,自己拥有的数据变成了数据可能性(likelihood),然后我可以把这两种数据结合在一起,就可以得到后验的概率,这就是DARTS的思想,我们把它称为深度学习辅助的RNA测序数据分析。

我们对此模型进行了各种各样的评估,例如有一个评估在对比两个不同的细胞间哪些异构体可能出现变化。横坐标是不用深度学习的信息,纵坐标是用深度学习的信息。可以观察到应用深度学习之后性能有明显提升。尤其当数据不够的时,得到的提升最高。如果数据很多,提升的效果反而有限。这进一步说明,我们可以用这样的学习架构,可以帮助提升小数据分析的能力。

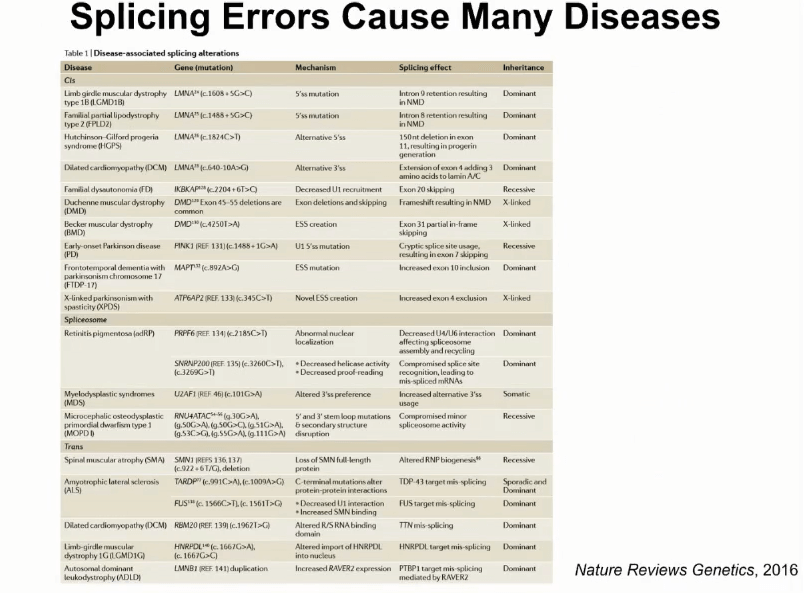

此模型还在进一步扩展。剪切是和很多的人类基因有关。2016年的时候在Nature Review Genetics上的一篇综述,这篇文章列举了一组导致人类疾病的剪切变异。实现在大家公认,所有人类致病基因突变概率在15%到60%,此估算范围比较大,其实50%-60%的概率基因突变和影响剪切有关。

那么,当知道哪些病人身上有基因组突变影响剪切,这对于病人诊断和病人治疗都会带来非常重要的帮助。现在的手段,例如遗传病检测,更关注的是此突变如何影响最后编码蛋白,而对于RNA功能的影响不是很关注。

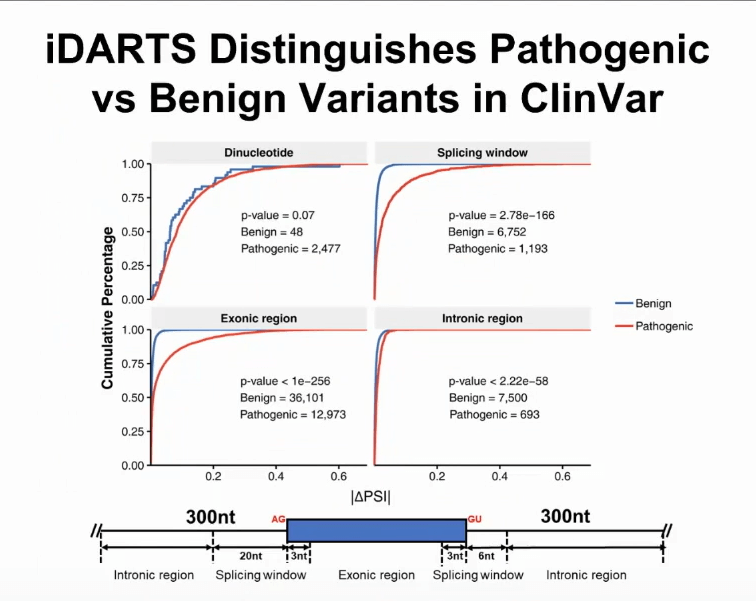

通过深度学习方法可以进行很好的预测,我们把DARTS深度神经网络进行了改进,新的模型称为iDARTS,字母i代表了个性化的DARTS分析。

iDARTS模型可以拿基因组里任何一个突变进行预测突变有没有能够改变剪切的水平。把模型用在数据库ClinVar上,医生就可以通过对遗传病人的分析,用专业知识得到的一组突变的数据库。

如果把iDARTS放在上图模型中,在各个基因组的区域,例如在外显子上面或者在内含子里面,都可以分辨致病基因突变和非致病基因突变。

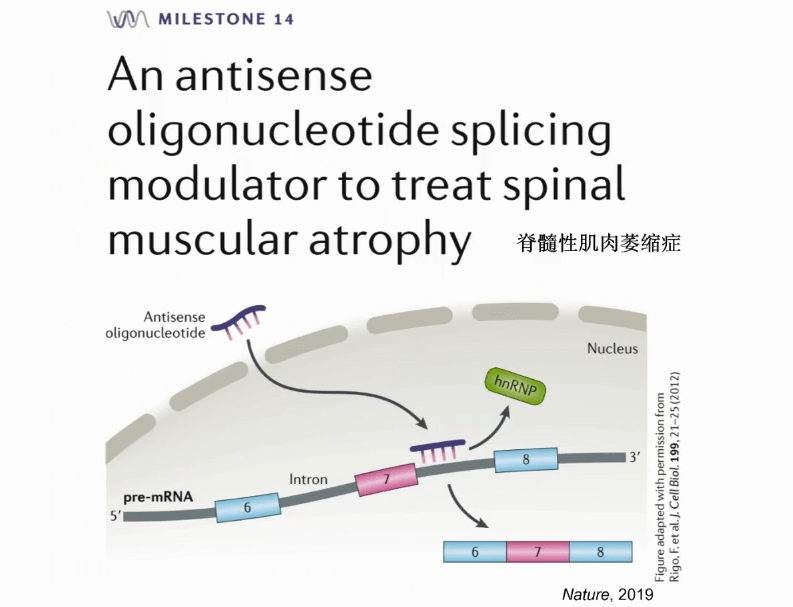

最后再给大家看一个例子,有一个剪切影响的疾病称为脊髓性肌肉萎缩症,这是非常糟糕的先天性疾病,正常患疾病的婴儿基本上存活时间不会超过两年。

此疾病的治疗靶点是一个基因名为SM2,一般的病人此基因的第7个外显子是被去掉的,会得到一个无功能的蛋白。我们需要进行的治疗方法是把此外显子保留到最后的RNA产物里面,从而得到一个有功能的蛋白。

在2016年的FDA批准了反译核苷酸的方式,能够作用在此RNA上,把第7个外显子包含进去,最后得到一个有功能的蛋白。这在当时一个非常激动人心的医学进展。虽然这个例子不是通过人工智能和大数据来完成的,是通过科学家在20年内非常艰苦的分子生物学的研究,搞清了机理,再开发了药物。但现在回头看,随着生物学技术、基因组技术、大数据和人工智能的发展,我们能够有非常高效的办法寻找到这样的治疗靶点,然后为这样的治疗靶点开发新的治疗手段。

丛乐:机器学习x基因技术:如何引入计算⼿段帮我们解决基因⽣物技术问题?

人物介绍:丛乐博士生于北京,先后就读清华大学电子系和生物系,在哈佛大学医学院获得博士学位,师从张锋和George Church教授。在张锋实验室实现了基于CRISPR的基因编辑技术,是超过20项该领域专利发明人,开发了基因编辑在脑科学、心脑血管基因治疗的应用。之后在麻省理工学院Aviv Regev教授研究组完成了癌症基因组学及单细胞计算生物学的博士后研究。在斯坦福大学,丛乐研究组致力于将基因编辑技术与人工智能结合,探索癌症和神经疾病的新疗法,与IBM和Chan-Zuckerberg Biohub开展了数个合作项目。先后在Science,Nature,Cell等杂志发表论文20余篇,专著2册,论文总引用量超过2万次。

为什么基因技术会特别受益于计算以及数据科学的发展?因为很多技术的发展,让我们拥有了大量数据,这个过程中基因编辑、基因测序的各种手段都需要一个更好方式来处理数据,机器学习正是这种“更好的方式”。

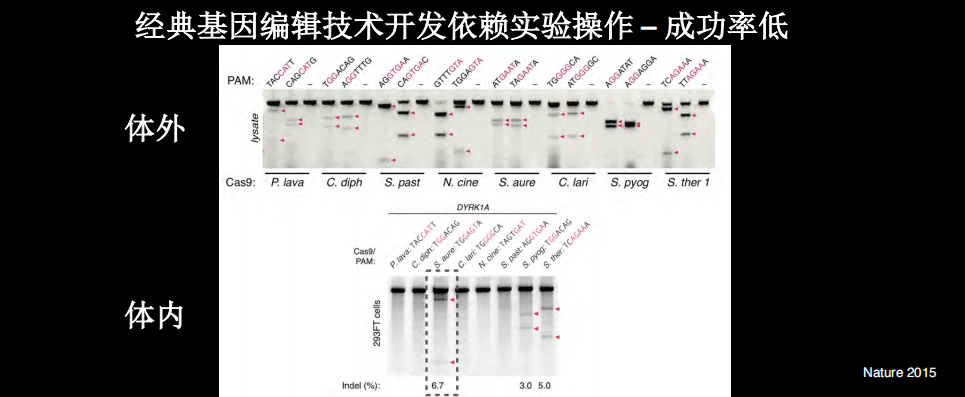

当我们利用人工智能以及计算生物学的手段帮助开发基因编辑的工具的时候。开发工具是很依赖实验操作的,时间花费特别大,有些产品可能也还不错,如果考虑到时间花费或者它的价格,“性价比”就不一定高了。

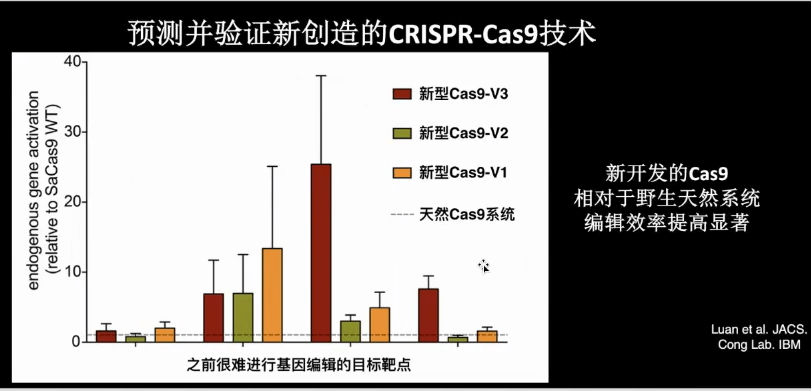

在做基因编辑工具的开发的时候,我们会做很多实验,大部分的情况下是体外实验,在上图实验中,我们检测了不同CRISPR的Cas9酶,我们找了很多自然界中的Cas9酶,我们都在体外要进行很多不同的序列检测,然后才能知道哪些具有基因编辑切割的活性。因此,经典基因编辑技术开发依赖实验操作,因此成功率很低。

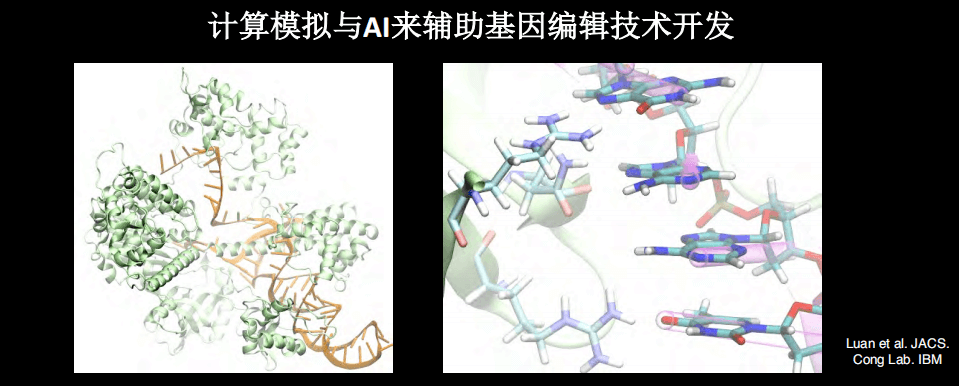

上图是大概两年前开始的工作,目的是希望通过计算机的模拟技术辅助基因编辑技术开发。主要用到的是生物物理和计算生物物理的工具,例如分子动力学和自由能变换。其实,很多时候蛋白的结构会给我们很大的帮助,因为我们有了CRISPR系统,就可以知道这个结构是如何的。

通过生物物理和计算的方法,包括分子动力学,我们就可以在计算机中看到CRISPR系统进行基因编辑的过程。如果有高质量的结构数据,将来有希望使用纯计算的手段进行实验,例如观察分子间的相互作用、预测基因编辑活性。

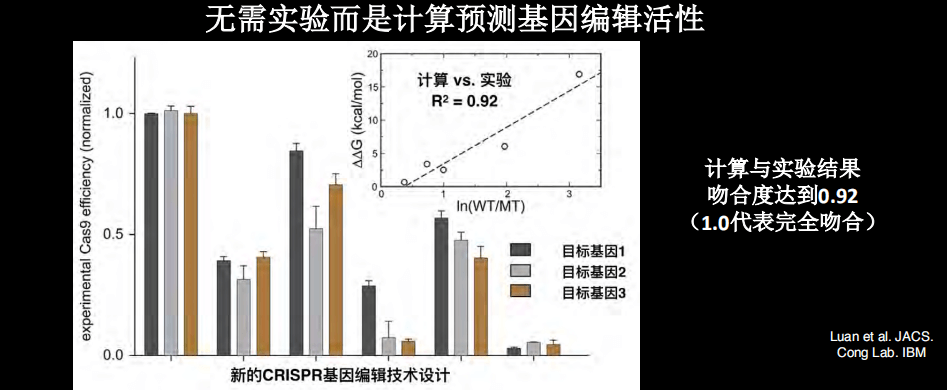

我们也做了蛋白质改造之后的基因编辑的设计,将计算的结果和实验结果相比较,发现几乎所有的预测和计算的吻合度非常高。

我们也设计了一些新的Cas9,例如我们可以合成几十、几百个Cas9蛋白,然后采用实验方法进行筛选。在实际实验中,我们测试了4个不同的改造后的新型的Cas9蛋白,趋向的是天然活性。结果是:改造的系统至少有两个效果非常好,4个中有3个都有一定的作用。因此,预测和验证新改造的CRISPR技术其实是一种可以实现的策略。换句话说,既然可以通过计算方法更好地创造基因编辑工作,那么就应用新的工具进行创新。

下面介绍一下我们最近的工作。既然知道可以用计算方法找到更好的工具,那么是不是能够用计算方法帮助找到哪些靶点治疗能够治疗疾病。

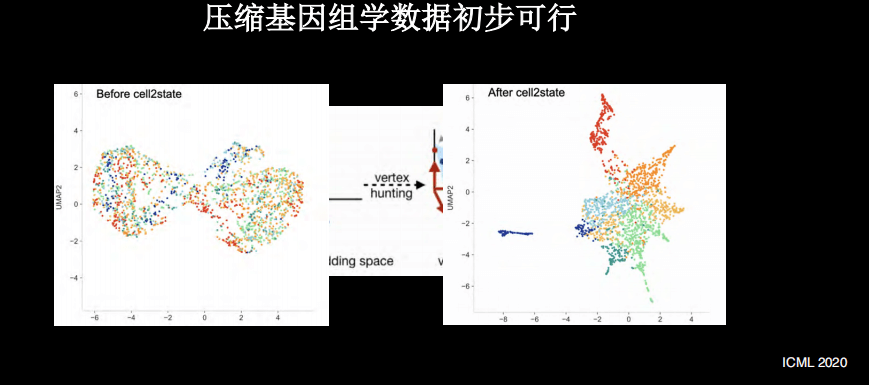

这个工作可以转化为:在单细胞测序相关的工作中,希望通过计算方法帮助我们更好地实现单细胞基因组学。

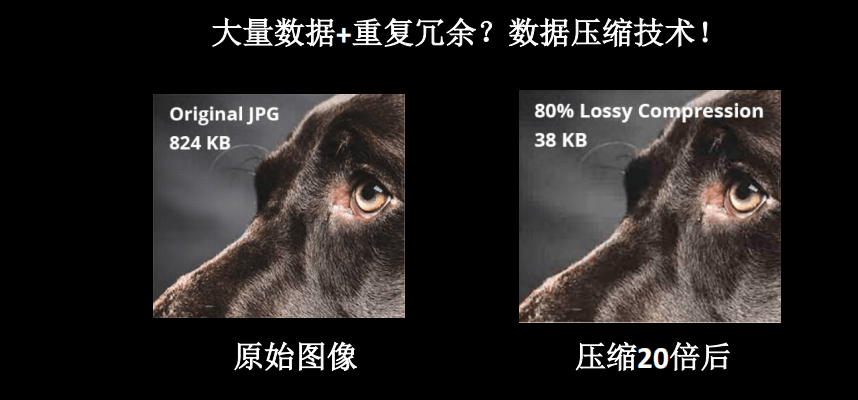

其实,通过单细胞的测序来找到药物靶点的灵感依然来自计算。在计算中,如果用手机发送的照片,很少是原始图像,通常采用压缩的技术。

如上图所示,原始图像压缩20倍之后,虽然丢失了一些信息,但其实大部分的重要信息都可以保留。例如狗的图片压缩之后仍然是狗,并没有信息丢失到猫狗不分的地步。因此,在生物数据中也可以尝试使用此手段。

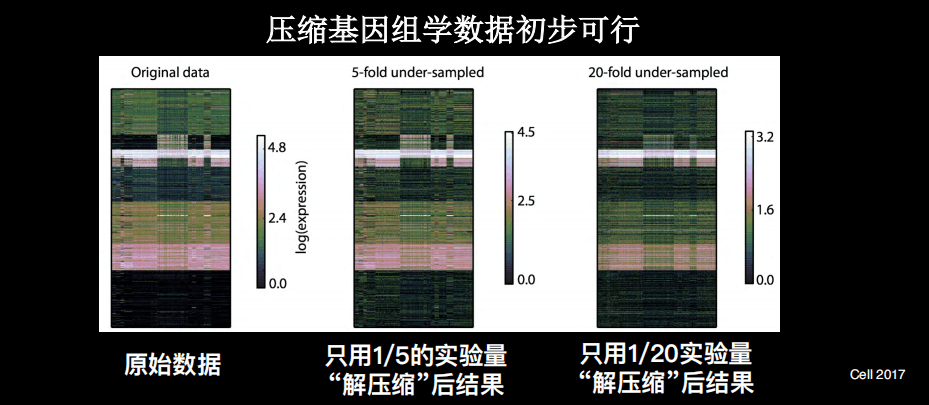

其实,在我博士后期间就开始探索了此类手段,即通过压缩和解压缩的手段来帮助我们更好地的理解基因组学数据。因为基因组学的数据中,也有冗余情况的存在。

上图是已经发表的一些单细胞的基因组学数据,颜色代表的是基因的表达量,每个横行是单细胞,纵列是不同样本。在进行数据处理之后,可以看到上述样本的分群,即使有5倍压缩,仍然可以发现重要数据。这时候仅需五分之一的测序量,就可以拿到重要的分群的信息,更进一步甚至是20倍的压缩。

另外,很多情况下如果不使用压缩手段,很多信息由于噪声,得不到清晰的细胞的分群。使用压缩手段之后,反而使得细胞分群更加清晰。

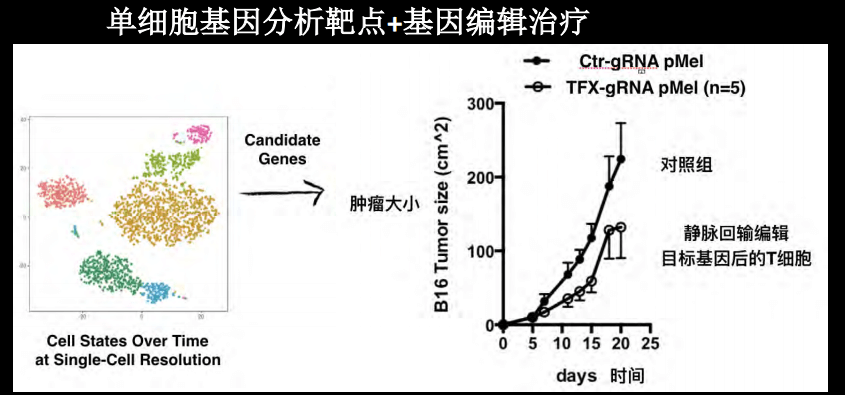

运用各种机器学习手段,既然找到关键基因,那么就可以使用更好的CRISPR工具进行编辑,我们特别关注的是肿瘤。最近尝试了一些工作是和一些肿瘤特别是肿瘤免疫治疗科学家的合作,通过单细胞测序分析出来的基因类点,然后进行单细胞的T细胞测序,用基因编辑改造目标基因,目前在治疗动物模型中得到了比较好的结果。

展望未来,我们希望在单细胞测序这种对精确的信息需求比较高的领域,应用大数据的分析之后,找到一些用于基因治疗技术应用的靶点。最后总结一下,我们期望通过计算模拟和新一代的压缩或者单细胞测序的技术,在模型中找到能够帮助治疗疾病的靶点,同时能够进行精确的编辑,从而可以实现底层技术加上不同学科之间的合作,从而帮助我们去理解复杂的疾病,并开展一些新的治疗方法。

▍ 跨学科讨论

AI对生物学的影响与人才培养

王皓毅:本次圆桌讨论的第一个方向是:AI赋能基因研究的科学价值及人才培养。下面请各位老师谈谈看法。

梁晗:AI技术对整个生物学的发展施加了非常深刻的影响。这种深远的影响分为三个层次:近期影响、中期影响、远期影响。生物体系是非常复杂的,以前研究的时候需要研究基础机制,往往需要花费的时间非常长。随着AI技术的助力,帮助我们直接跳过机制基础研究阶段,直接把底层的基因层面的信息和表层信息进行了非常精准的对接。虽然具体的生物模型不是很清楚,但可以通过很多微妙特征的叠加组合得到非常准确的模型。这可以在很大程度上提高生物开发研究的周期和速率。换句话说,用AI技术可以超越以前很多传统的应用。

中期会有什么影响呢?随着AI技术的发展,改变了整个科研模式。因为通过和AI对话可以有效实现资源共享。另一方面,人类可以将AI作为智能伙伴,在帮助我们从非常繁琐复杂的任务中解放出来的同时,也改变了我们对于知识吸收和开展科研工作的模式。

举个简单例子,之前,在实验室刷瓶子可能需要很多人,后来引进了高速的洗试管的机器,这种资源的重新配置虽然不一定降低成本,但却把人类的创造力解放了出来。

其实,真正最激动人心是长期效果:超越死亡。科研中最大的浪费是什么?最大的浪费是死亡。一个经过几十年训练卓有成就的科学大家,如果他死亡了,那么那一刻他所有的知识就烟消云散了,后人很难把他的知识传承下去,唯一的知识传递就是阅读文章。

在未来,如果我们能够通过AI的技术,用AI集成科学家的思想,换句话说对于一个生物信息工作者,在某种程度上就实现了传承和永生。其实,这对于人类文明知识的积累和爆发式的前进是有着长远的意义。

王秀杰:AI的科学价值不容置疑,在很多方面存在挑战,同时也有很多机遇。我重点谈谈AI+教育,AI会改变一些研究范式,这种改变对于将来的学生来说,需要学的知识非常多,毕竟进入这个行业并不像以前一样单纯学习一门学科就行,这个行业目前需要很多学科知识的融合。

另一方面,这些学生考虑未来,其实有很多机会。但如果长远来看,十年、二十年之后,AI+生命科学和AI+医学等领域会不会存在资源导向,形成一些垄断。

通俗一些,现在很多实验室在开发一些算法,但是我们过去看到AlphaFold横空出世,超过了很多进行蛋白质预测的实验室。目前开发的一些算法和应用一方面依赖于数据,另一方面需要计算力。

未来进入这个行业的年轻人应该考虑的是:作为此领域的科学家,如何平衡研究和产业化?我们的目标都是为了让人工智能和生命科学、医学进行更好的结合,从而更好造福人类。

王皓毅:王秀杰的想法非常值得思考,资源的垄断是个根本问题,其他领域已经出现了苗头。机器学习提高了能力,但机器算法有一个黑箱子,人类的机制理解并没有提高。AI真正渗透到将来的数据分析之后潜在的不确定性,卜东波老师有什么评价。

卜东波:AI尤其是深度学习,的确相对于传统统计模型有很大改善。举个简单例子,我们设计统计模型的时候,经常有一些假设,假设数据服从高维的正态分布。高维正态分布的要求,需要一维、二维的边际分布都是正态,这是非常强的假设。

这个假设是错误的时候怎么办?统计学家给出的解释是,如果不设计此假设的话,一些重要的数学公式无法推导。AI和大数据就大大改善这一条件。毕竟,在大数据处理中,数据无论服从什么概率分布,AI都能解决。这也回答了为什么AI+大数据会有效,因为它改变了传统统计建模的一些不正确的假设。

邢毅:我来谈谈“如何在AI和生物医学交叉领域培养人才”。我在进入现在的工作单位之前,我在美国西部加州大学洛杉矶分校工作五年,那时候我负责UCLA生物信息学博士培养项目的管理,我们当时经常讨论的问题是:在这样一个交叉领域,如果想要接受一个训练,想着自己以后成为一个什么样的人才的话,可以有三种定位:开发者、应用者、合作者。对于开发者,可能需要开发新计算工具,开发人工智能工具,用它分析解读生物医学的大数据,此类人才,需要在各种各样的基础算法和数理的基础上有比较深的知识。其实很多同学不需要这么专业的知识,但是可能需要在科研过程中需要和很多做这方面工作的开发人员有交流。因此,不管是哪种人才,都需要在自己领域里钻研专业知识;另外,要有广泛的阅读和广泛的训练,你可以知道别人在想什么,别人是用什么样的术语来思考问题,这样在一个比较大的组织下可以和别人有效的交流。

梁晗:每个人面对自己发展的时候都要有定位,此定位可以根据兴趣爱好和知识储备。如果想理解未来AI技术在整个生物领域各个方向的巨大影响,需要打下非常广泛的基础,至少要保证交流时有共通语言。

其实,科研的过程就是获得自由的过程。就像人类在很早的时候可能没有汽车,移动的距离很近,不可能超过方圆十公里。发明汽车之后,我们可以移动的距离就很远了。

AI其实是非常强大的技术,可以帮助每个科研工作者在他的领域实现更大的自由。这种能力和人有互补性,计算机有超强计算能力、超强记忆力,它可以把准确预测能力发展到极限。而人类有非常好的直觉能力,甚至人类可能有一种非理性的跳跃性的思维,很多时候可能把我们从一个局限中跳跃出来。所以,我认为人类所具有的本能能力和AI能力结合在一起,会给科研发展提供更大的自由。

AI赋能带来的风险以及应对策略

王皓毅:第二个问题,AI加速基因新技术带来的风险和应对策略,大家有什么考虑。

丛乐:从我自己的角度来看,之前做实验的规模相对比较小,现在有了很多特别好的工具,就可以更容易,之前所有的这些新工具,可以降低门槛,可以让我们分析更多的数据。

我们无法判断此技术走向或者它如何使用,用户最终决定了这个技术如何被使用,所以在门槛降低之后,可能需要我们思考如何使用。一方面数据如何保护隐私,另一方面就是,到某种层面之后,如何通过手段监管,因此监管变得非常重要。

胡晋南:提到风险,做学术和做企业、做产品很多时候的思维侧重点不一样。举例而言,在临床环境下,将一个癌症病人的各种信息输入,然后模型可以给出癌症病人治疗恢复效果,模型预测结果可能是很差。但深度学习无法给出为什么,只能给出一个判断好坏的分数。

这个问题不解决,它就永远没有办法进入临床这种高应用价值、高风险的环境下。

梁晗:人类回顾历史会发现,汽车出现以后,马车就不用了,当电子邮件出现的时候,以前送信的邮递员就大幅减少了,甚至当工业出现纺纱机的时候,纺纱女工就大规模失业了。

所以,当AI技术出现的时候,我们所面临的一个很大的问题就是社会职业的消亡和整个社会资源的重新匹配,这个过程中社会就会有很大动荡。

再者,大规模的公开资源垄断,当有AI技术的时候,数据和技术在,它和人之间的差距被迅速扩大,这里有一个如何更有效的实施数据民主化或者数据去中心化,比如结合最新的数据存储技术避免这种垄断,变成人人可用,这是开源的重要意义。这也是非常重要的一点,在未来,无论从立法上还是数据跨度上,可能要更明确,要设置防止垄断的规则。

最后,人作为万物生长要和自然和谐相处,未来我们可能面临的一个很重要哲学课题是人和AI智能之间如何相处,这种发展可能以前只在科幻小说里出现,现在我们切实感受到这种发展近在眼前,因为AI技术的发展是指数型的。

王秀杰:我想补充一点关于风险的问题。回归到AI+基因组学和生命科学或者医学本身,不管是基础研究,或者公司,或者医疗机构,最终是期望用AI来帮助人类有更健康、更好的生活状态。但是用AI来做销售预测、金融分析,比较困难的一点是因为人是很复杂、很动态的。比如销售预测,一个人过去喜欢的,他不太容易在未来很短期就发生变化。但是这个人不一样,比如今天状态不好,明天开始,每天跑马拉松,很多状态就不一样。AI和基因组学结合,包括生命科学本身多层次的调控,从DNA层面的,到三维层面的等等,细胞间的交流,其实有很多不确定性。不管是从研究机构还是从医疗机构甚至普通百姓,也许对AI+生命科学的期望和AI+其他领域的期望是不太一样的,就是AI+生命科学,它并不是基于既往数据会给出一个固定的、非常准确的预测结果,仅仅是一个参考。所以大众应该有这样一个心理预期,这样对于AI+生命科学、AI+医疗也许是更好的发展状态。

王皓毅:风险就是不要过度解读。不要被很多人忽悠。最后一个问题,AI+基因科学的产业化应用和价值,。

胡晋南:现在无论是在国内还是在硅谷,我们能看到AI+基因公司多如牛毛,每家都说自己做的最好,但我们一定要很平常心的看待这个问题。首先价值创造流程链条很长,AI、基因组分析,到下游,到反馈,但是整个社会最终愿意买单的环节集中在最后,比如药厂愿意为药物开发买单,患者、医生愿意为他临床决策买单,上游部分,你开发一些软件也好,一些模块也好,

整个社会并没有太多买单意愿。整个链条中的每个板块都是有很多块,公共训练集很多,文章每个月大量的都出来,里面有直接做出学术成果,但是文章转化成实际应用的技术有很大的距离。

社会上经常看到XX大学开发了癌症检测方法,第一段就给出一个结论,85%可靠性。实际上这离真正的实用有很大距离,这是没法作为一个筛查手段来使用的。

因此,牵扯到另外一个问题,在我们行业里我们真正需要做产品、做用户,能够给用户创造价值愿意买单的产品,但是有些公司希望做的比较全,帽子戴的比较大,一个公司用AI解决很多问题,并不是解决某个特定问题,而是一整套,典型的例子是IBM的沃森,那个不断提高公众对行业软件的期待值,最后也是摔的比较惨的。所以,这并不是针对用户买单的方面,可能主要针对的是资本市场的关注。

开发医疗软件和互联网的思维是不一样的。在硅谷比较典型,和学术机构的前沿相配合,从中选择有市场价值的技术进行开发,最终一个点一个点的去突破,从而真正提升AI在基因领域真正的应用价值。

邢毅:过去几年AI和基因技术的结合在产业界非常火,有很多的初创公司或者一些大公司也都在进入这个领域。任何一个领域火的时候都有泡沫,之所以火也有原因,我们需要做的原因怎么把气泡挤破,真正做有影响力、能够做出事情来的工作。

梁晗:在产业化过程中,AI能够把大数据的力量极致化。最早的时候大家看病根据医生经验。目前,药厂越来越依赖于大数据寻找药物靶点进行开发,找到药物靶点后,如何找到好的生物标识锁定真正受益人群,大数据越来越有用。

随着高度AI技术发展,制药产业会去中心化,一个大药厂越来越可能不把每一步环节都紧紧抓在自己手里,而是形成了很多服务性的企业。在未来的产业发展中,一个企业不太可能包打天下,而事实上它和很多伙伴企业形成一种联盟,每个伙伴企业需要在自己关注的问题上深耕。这个深耕需要两件事,一是有AI技术,二是有非常强的知识积累,还要有非常强的经验,新药研发的过程就更像不同联盟各个企业合作。

胡晋南:我看到的情况稍微有点不一样。现在很多药厂意识到AI的价值,他们愿意花很大力气把事情做起来。优势是什么呢?就是数据,这些数据在药厂手里,他绝对不会贡献出去,他只会在内部把数据最大化。

另一方面,去中心化也不同。第一,AI领域很多时候性能好不好,通过比较就能知道结果。第二,它没有所谓的服务问题,并不是服务了一家药企就没有精力服务另外一家药企了,而且它自适应能力非常强,在一家做好了,对第二家肯定也是一个加分项,第二家做好了做第三家就更容易了,因为他在不断吸收前面的经验。所以,我个人感觉,在药企服务领域很快就会出来一个垄断者。

梁晗:大家可能存在误区,提到大数据,生物医学大数据,大家可能想到的是样本,但大数据不只是这个,大家可以跳跃思维。像Dr.Right其实也用了很多大数据,但实际上用的不是那种基于样本的(Sample Based),而是每个人分析数据的过程可能就是一个反馈(Feedback)。

AI的赋能远远超过了我们能想像的。第二件事情,每个领域有很多细分的小地方,它需要有一个人用匠心专注,他可能在一个很小的地方就能用AI,这样一个小的应用,小公司也可以做到极致,就会创造很多机会。不可能期待一个大的药厂,就跟组装汽车一样,每一个零件它能做到极致,而往往是一个小的公司只要找到自己足够的位置(inche),它自己能建立起自己的技术壁垒,可能这个技术壁垒是不为人知的一个小的“技巧”,它可能有独特的先进性,大的企业有它们自己的问题,包括它们的决策、资源分配、效率问题。

王皓毅:几位老师说的不矛盾,现在药厂也是在跟很多小的BioTech合作,包括收购很多小的BioTech,可能在一些更具体的现有应用上,药厂的资源和积累,它可以很快将AI落地。无论如何,多样性是生物进化的原动力,也是我们科学存在的价值。

AI+生物的天花板

王皓毅:蛋白质结构预测,AI蛋白结构预测的天花板是什么?是冷冻电镜数据吗?从基因序列推演到蛋白结构到底还有多远?这种重头预测(de novo)的天花板是什么?

卜东波:现在的重头(de novo)预测虽然有所进展,但还面临很大困难。现在适合我们这种方法还是基于共进化原理,如果一个待预测蛋白质,构造出来的MSA条数非常少,发现不了共进化,这时候这种方法基本没有办法用,这是当前很大一个困难。

至于天花板,我对这种方法的天花板到底是什么也没有概念。还有同学问标准答案,标准答案都是用的冷冻电镜,还有晶体演示的结构作为标准答案。但是这里也有一个问题,虽然我们这个领域有标准答案了。可是人体内的蛋白也是不断在“动”,所以这个标准答案很多区域是动态的,所以这个标准答案也不是那么标准。本身标准答案还有一些问题,天花板肯定还是很受限。

王皓毅:Dr.Right是否可以帮助我们对已发表文章数据的可靠性进行分析和检测?Dr.Right的AI模型是全新开发的,还是基于现有的AI架构?

梁晗:目前对于一些公共数据基于TCGA,我们已经在应用。另外,我们采用了现有工业界非常流行的NLP包,能够有效认识一些关键词。同时基于自己的行业经验,加以改进。而背后的AI的模型,时间对称打分的模型是我们自己完全开发的,并且随着用户的不断数据进来,可以不断地更新,最后会变得越来越准确。假设将来会有一天,你的文章自然语言写出来,应该可以通过机器直接读懂自然语言,至少在计算层面上,如果你的数据链接不是可获得的,应该可以直接把东西设计出来。

目前公认的是,数据不可重复性是生物医学文章发表很重要的一个问题。这件事情之所以不能监督的主要原因是:因为重复、分析这些东西太耗时间,太耗精力,如果我们能够通过AI的技术,有效的把门槛降低,把时间消耗成本降低,对于整个生物医学文章发表的可靠性、质量就会非常有力的推进。

王皓毅:在AI的分析过程中它的透明度和可解释性如何?

卜东波:我们现在对AI的定义稍微有点太过于泛化了,当前我们AI实际上是狭义的,指的就是神经网络,传统的网络其实有三条路线,一条是逻辑主义,一条是联结主义,现在还有一些是依据实例进行学习。现在我们AI是指的狭义的神经网络,没有逻辑。神经网络面临一个很大的问题,它是黑箱子,我们对中间的过程认识不够,我们打不开它,或者打开它之后还是分析的不透彻。如果要解释清楚的话,因果学习可能是更重要的,对于医学应用当中大夫的判断,如果只是神经网络给出了一个分数,例如没有解释,肯定在实际应用中也会存在很大困难。这时候因果推理可能可以部分解决这个问题。

梁晗:我小时候如果做一道数学题特别难,老师问我怎么解,我不会。老师会告诉正确答案是C。其实,在告诉答案的那一刻就能够启发题目如何选择C。某种程度上AI可以帮助我们起到这个作用,比如基因层面的表型,也许我们不知道中间在机制层面到底是如何传导。但是,如果我们能够在某种程度上先知道它有可能导致的是哪个机制,哪个表型(phenotype),帮助我们重新梳理机制或者更有目的性的探索机制,它可能是有效的。

AI最起码会给出提示作用,这样就人为降低了我们最终对它的理解难度。这其实就是哲学上的问题,究天人之际,在一定层面上人类对纷繁世界的认知限制住了,所以我们如果再插上AI的翅膀,是有可能在某种程度上理解未知。因为,我们的思维力、计算力能够通过AI被提高。

梁晗:这里存在误区,我曾经专门写文章叙这件事情。我们进行生物标记物(biomarker)预测时,只用关心此预测能否对病人最大有效,因为最终评价效果是能不能使病人有效,如果这个方法比传统的方法更有效就使用它,无论是否理解背后的机制。

很多时候,在科学研究上,我们需要理解背后的机制,但是在病人受益上,如果病人快死亡了,在药物选择上,AI技术告诉A药可能让病人受益存活,在那个时候就应该使用A药治疗,只要AI证明了我们比传统上不经过AI的模型有更高的准确性,就要给他用药,至于理不理解它背后的机制,在那个时刻不重要,因为救人最重要。

学识背景与人才发展路径

王皓毅:关于人才培养,如何在生物背景薄弱的情况下依然可以在生物医药领域发展?反向的问题是:如何在生物信息背景薄弱的情况下,能够快速进入AI和人共生的科研体系?

邢毅:这个我可以来说几句,我个人感觉,如果生物背景薄弱,但是数理计算背景特别强,想进入生物信息,比反方向进入更容易,毕竟基础在那里。当然也需要浓厚的兴趣。对于计算背景的人进入生物领域,会存在障碍,例如统计专业的同学,喜欢处理非常漂亮的数据,然后发展各种各样的统计模型。实际上真实的生物医学数据是非常脏(dirty)的,而且有很多批次效应。反过来,生物专业的同学想进入到生物信息或者AI领域,建议是根据自己以前的知识背景和积累,决定自己的定位。根据定位,可以进行一些自己的规划。

我们也碰到过很多的同学在本科的时候,可能数理背景并不强,但他们爱钻研,于是学习了很多知识,读研究生的时候可以有方向性的选数学、统计、计算机科学的课程。

王秀杰:同意邢毅,早期做生物信息的生物背景的人很少,很多都是数理、统计。现在涉及到对基因组的生物功能的解读,其实生物背景可能用现有工具就会有更好的产出。因此,任何一个领域,尤其是现在AI+基因领域需要不同背景的人参与,当然对多方面都有了解是比较好,但是总要有一个专长,这个专长无论是计算机、数理还是生物,总有自己的一个定位(inche),根据自己的背景和特长爱好,找到自己喜欢又能够发挥才能的方向是比较重要的。不要因为怀疑自己的背景没有优势,其实,哪个背景都有优势。

梁晗:很多人可能喜欢AI,实际上在技术层面,可能在很多时候被我们忽略了,对思考生物学的问题要有哲学层面的高度思考,不要让自己的思维永远停留在技术层面上,换句话说永远在推动(Push)数据后面的两位数,到底是91.28还是91.32。生物体系之所以复杂,背后有很多很深刻的规律。

所以,不管学生物的同学还是学AI的同学,在很大程度上要把自己的层次拉高一些,读一读多年前的先贤文章,这样能够有效帮助我们避免在低端层面的竞争。

王皓毅:我们对生命的理解太肤浅了,当我们谈一个问题的时候,当我们谈一个基因型的时候,其实并没有谈这个人的不同细胞的基因变异,我们默认这个人的基因型,实际上检测的只是血液细胞。但是你身上不同细胞的基因是不是一致。目前,单细胞基因组学,DNA层面还是技术上发展的,我们有70%、80%的序列是重复序列构成的,这些重复序列的精确拼接和相关性(Correlation)是非常欠缺的,有很多问题是没有被很好的解释。因此,学会提问题非常重要,因为作为学生,还年轻,如果提出最重要的问题,才可能解决拓展人的知识边界。

AI+生物的未来

最后,请各位发表结束感言。谈谈希望,谈谈预期或者谈对年轻人的建议。

王秀杰:AI已经来了,已经在改变我们的生活和世界。而传统教育并没有对于未来的规划。所以此阶段希望同学们能够想的长远一点,用更大的视野观察未来AI对生活、科研以及每个人的事业带来怎样的影响,及早做好规划和准备。

梁晗:AI是真正赋能的过程,能够使我们科研上效率不断提高。在科研上最重要的一点,是保持自己的独立思考和自由的精神,这是最本质的。

邢毅:生物信息、大数据和各种各样多科学交叉的领域,现在是非常激动人心的领域。在学术界、工业界、产业界存在很多的机会。今年3万个碱基的RNA(新冠病毒)把全世界折腾人仰马翻,希望有更多的同学或者做相关方向的老师能够参与到这方面的工作,真的是有很多的机会。

卜东波:对于交叉学科来说,每个人都要先有明确的定位。以生物信息为例,这作为一个重要的交叉学科,学生一定要有扎实的基本功,守住本行,成为专家。另外,对其他行一定要懂,保持兴趣,要有强烈的好奇心。

王皓毅:随着工业革命,人类社会加速发展,AI革命可能会再上一个台阶,当前我们还在盲人摸象、刻舟求剑。我们对生物的研究,所知甚少。我们总是在用过去的经验和今天的判断不自觉的预测未来的事情,但是,搭载AI引擎的这条驶向未来的船可能“越来越快”。

希望我们能够保持热情,保持对生活的享受和对生活的非功利主义的好奇心,因为这是驱动你在任何新环境下能够自我学习、能够享受人生的重要内核。